یادگیری ماشینی روش برخورد ما با مسائل پیچیده و تصمیم گیری را متحول کرده است. یکی از مهیج ترین و امیدوارکننده ترین شاخه های یادگیری ماشینی، یادگیری تقویتیRL Machine Learning است.

RL نوعی از یادگیری است که در آن یک عامل یاد می گیرد که با تعامل با محیط و دریافت بازخورد به شکل پاداش یا تنبیه تصمیم گیری کند.

در هسته خود، RL از روشی که انسان ها و حیوانات از طریق آزمون و خطا یاد می گیرند الهام گرفته شده است.

درست مانند یک کودک راه رفتن را با برداشتن گامهای کوچک و تنظیم حرکات خود بر اساس بازخوردی که دریافت میکند، یاد میگیرد، الگوریتمهای RL نیز یاد میگیرند که با بررسی اقدامات مختلف و مشاهده عواقب، تصمیمات بهینه بگیرند.

RL machine learning

ایده کلیدی پشت RL یافتن تعادل بین اکتشاف و بهره برداری است. در ابتدا، عامل با انجام اقدامات تصادفی و مشاهده پاداش هایی که دریافت می کند، محیط را بررسی می کند.

با گذشت زمان، شروع به بهره برداری از دانش خود با انجام اقداماتی می کند که در گذشته پاداش های بالایی را به همراه داشته است.

این مبادله اکتشاف و بهره برداری برای الگوریتم های RL برای یافتن بهترین خط مشی ممکن بسیار مهم است.

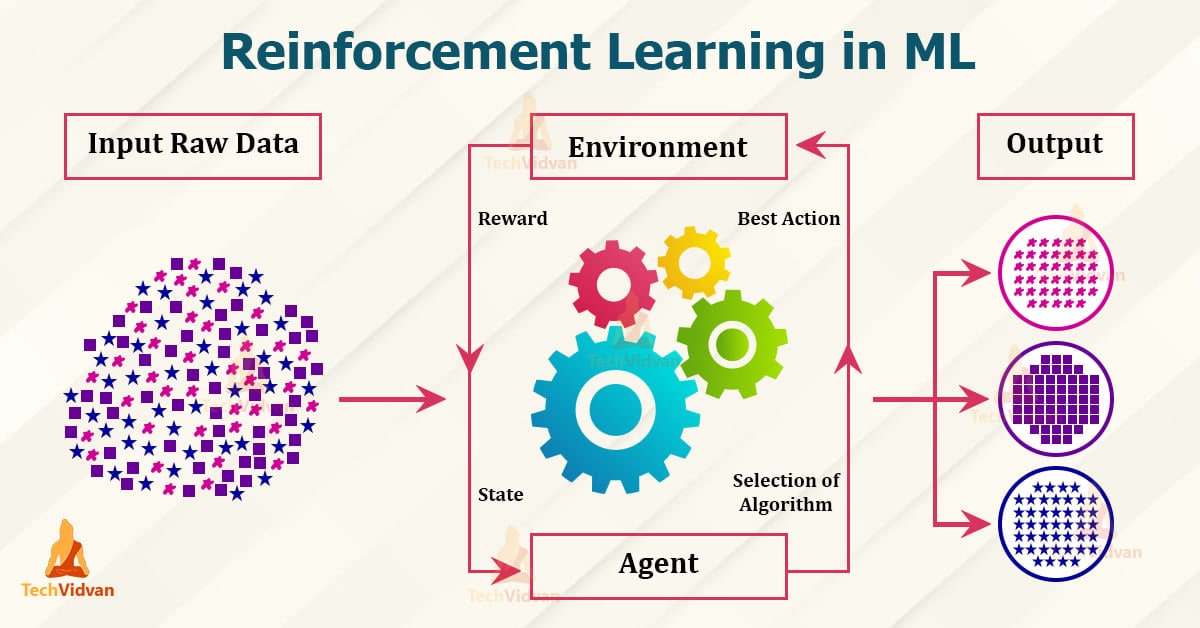

یکی از مفاهیم اساسی در RL مفهوم عامل و محیط است. عامل یادگیرنده یا تصمیم گیرنده است، در حالی که محیط سیستم بیرونی است که عامل با آن تعامل دارد.

عامل اقداماتی را در محیط انجام می دهد و محیط با پاداش ها و حالت های جدید پاسخ می دهد. هدف عامل این است که سیاستی را بیاموزد، که نقشه برداری از حالت ها به اقدامات است، که پاداش تجمعی را که در طول زمان دریافت می کند، به حداکثر می رساند.

برای رسیدن به این هدف، الگوریتم های RL از تکنیکی به نام تکرار ارزش استفاده می کنند.

تکرار ارزش شامل تخمین ارزش هر حالت در محیط است که نشان دهنده پاداش تجمعی مورد انتظاری است که عامل می تواند از آن حالت به بعد به دست آورد.

با بهروزرسانی مکرر این تخمینهای ارزش بر اساس پاداشهای مشاهدهشده، عامل میتواند تصمیمگیری بهتر را یاد بگیرد.

یکی از چالش های موجود در RL مسئله اکتشاف است.

از آنجایی که عامل برای یادگیری بهترین خطمشی نیاز به بررسی اقدامات مختلف دارد، اغلب بین انتخاب اقداماتی که بهعنوان پاداشهای بالا شناخته میشوند و کاوش در اقدامات جدیدی که ممکن است به پاداشهای بالاتری منجر شود، با دوراهی مواجه میشود.

برای مقابله با این چالش، الگوریتمهای RL از استراتژیهای اکتشافی مختلفی استفاده میکنند، مانند epsilon-greedy، که در آن عامل بیشتر اوقات اقدامی را با بالاترین ارزش تخمینی انتخاب میکند، اما گاهی اوقات اقدامات تصادفی را بررسی میکند.

RL با موفقیت برای طیف وسیعی از مشکلات، از انجام بازیهای پیچیده مانند Go و شطرنج گرفته تا کنترل وسایل نقلیه و روباتهای مستقل به کار گرفته شده است.

در واقع، الگوریتمهای RL در بسیاری از حوزهها به عملکرد فوقانسانی دست یافتهاند و از متخصصان انسانی پیشی گرفتهاند.

این موفقیت را می توان به توانایی الگوریتم های RL در یادگیری از تجربه و تطبیق رفتار خود بر اساس بازخوردی که دریافت می کنند نسبت داد.

در نتیجه، یادگیری تقویتی شاخه قدرتمندی از یادگیری ماشینی است که عوامل را قادر میسازد تا سیاستهای تصمیمگیری بهینه را از طریق آزمون و خطا بیاموزند.

الگوریتمهای RL با کاوش در اقدامات مختلف و مشاهده پاداشهایی که دریافت میکنند، میتوانند تصمیمگیری بهتری را در طول زمان بیاموزند.

علیرغم چالشهای اکتشاف و بهرهبرداری، RL موفقیت چشمگیری در حوزههای مختلف از خود نشان داده است و همچنان مرزهای آنچه را که در یادگیری ماشینی ممکن است در پیش میگیرد.

درک مبانی الگوریتم های یادگیری ماشین RL

یادگیری تقویتی (RL) نوعی از الگوریتم یادگیری ماشینی است که سیستم هوش مصنوعی (AI) را قادر می سازد تا یاد بگیرد و از طریق آزمون و خطا تصمیم بگیرد.

این یک تکنیک قدرتمند است که در سال های اخیر به دلیل توانایی آن در حل مسائل پیچیده و دستیابی به نتایج چشمگیر مورد توجه قرار گرفته است.

در این مقاله، ما اصول اولیه الگوریتمهای یادگیری ماشین RL را بررسی میکنیم و نحوه عملکرد آنها را درک میکنیم.

در هسته خود، RL مبتنی بر مفهوم یک عامل در تعامل با یک محیط است.

عامل اقداماتی را در محیط انجام می دهد و بازخوردهایی را در قالب پاداش یا جریمه دریافت می کند.

هدف عامل این است که پاداش انباشته ای را که در طول زمان دریافت می کند با یادگیری اینکه کدام اقدامات منجر به نتایج مثبت می شود و از کدام یک باید اجتناب شود به حداکثر برساند.

یکی از اجزای کلیدی RL مفهوم یک سیاست است. خط مشی یک استراتژی یا مجموعه ای از قوانین است که عامل برای تعیین اینکه در یک وضعیت معین کدام اقدام را انجام دهد، از آن پیروی می کند.

خط مشی می تواند قطعی باشد، به این معنی که همیشه همان عمل را در یک حالت مشخص انتخاب می کند، یا می تواند تصادفی باشد، به این معنی که اقدامات را به طور احتمالی بر اساس توزیعی انتخاب می کند.

برای یادگیری یک خط مشی بهینه، الگوریتم های RL از تکنیکی به نام تکرار ارزش استفاده می کنند.

تکرار ارزش شامل تخمین ارزش هر حالت در محیط است که نشان دهنده پاداش تجمعی مورد انتظاری است که عامل می تواند از آن حالت به بعد به دست آورد. ارزش یک حالت معمولاً با در نظر گرفتن پاداش های مورد انتظار از انجام اقدامات مختلف و انتقال به حالت های مختلف محاسبه می شود.

رویکردهای مختلفی برای تکرار ارزش وجود دارد که محبوبترین آنها یادگیری Q است.

Q-learning یک الگوریتم RL بدون مدل است که تابع ارزش عمل بهینه را یاد می گیرد که به عنوان تابع Q نیز شناخته می شود.

تابع Q نشان دهنده پاداش تجمعی مورد انتظاری است که عامل می تواند با انجام یک اقدام خاص در یک وضعیت معین و پیروی از سیاست بهینه پس از آن به دست آورد.

در طول فرآیند یادگیری، عامل با انجام اقدامات تصادفی و به روز رسانی عملکرد Q بر اساس پاداش هایی که دریافت می کند، محیط را بررسی می کند.

با گذشت زمان، تابع Q عامل به مقادیر بهینه همگرا می شود و سپس می تواند از این دانش برای تصمیم گیری آگاهانه و به حداکثر رساندن پاداش خود استفاده کند.

یکی از چالش های RL، مبادله اکتشاف و بهره برداری است. اکتشاف به توانایی عامل برای آزمایش اقدامات مختلف و یادگیری در مورد محیط اشاره دارد، در حالی که بهره برداری به توانایی عامل برای بهره برداری از دانش فعلی خود برای به حداکثر رساندن پاداش اشاره دارد.

ایجاد تعادل مناسب بین اکتشاف و بهره برداری برای عامل برای یادگیری یک خط مشی بهینه بسیار مهم است.

برای مقابله با این چالش، الگوریتمهای RL اغلب از یک استراتژی اکتشافی مانند epsilon-greedy یا softmax استفاده میکنند که احتمال انتخاب یک عمل تصادفی در مقابل اقدام بهینه را بر اساس دانش فعلی عامل تعیین میکند.

این به عامل اجازه می دهد تا در ابتدا محیط را کاوش کند و به تدریج به سمت بهره برداری از دانش آموخته شده خود با اطمینان بیشتر حرکت کند.

در نتیجه، الگوریتمهای یادگیری ماشینی RL سیستمهای هوش مصنوعی را قادر میسازند تا یاد بگیرند و از طریق آزمون و خطا تصمیم بگیرند.

با تعامل با یک محیط و دریافت بازخورد در قالب پاداش یا جریمه، عامل یک خط مشی بهینه را می آموزد که پاداش تجمعی خود را در طول زمان به حداکثر می رساند.

از طریق تکنیکهای تکرار ارزش مانند یادگیری Q، عامل ارزش هر حالت را تخمین میزند و تابع ارزش عمل بهینه را میآموزد.

مبادله اکتشاف و بهره برداری از طریق استراتژی های اکتشاف مورد بررسی قرار می گیرد و به عامل اجازه می دهد تا تعادلی بین آزمایش اقدامات جدید و بهره برداری از دانش آموخته شده خود ایجاد کند.

RL ثابت کرده است که یک تکنیک قدرتمند برای حل مسائل پیچیده است و در حوزه های مختلف از جمله روباتیک، بازی کردن و سیستم های مستقل کاربرد دارد.

کاربردهای یادگیری ماشینی RL در سناریوهای دنیای واقعی

کاربردهای یادگیری ماشینی RL در سناریوهای دنیای واقعی

یادگیری ماشینی RL یا یادگیری ماشینی تقویتی، یک تکنیک قدرتمند است که در سالهای اخیر توجه زیادی را به خود جلب کرده است.

این زیر شاخه از هوش مصنوعی است که بر آموزش عوامل برای تصمیم گیری بر اساس آزمون و خطا تمرکز می کند.

برخلاف سایر رویکردهای یادگیری ماشینی، RL برای یادگیری به داده های برچسب دار نیاز ندارد.

در عوض، از طریق تعامل با محیط خود، دریافت بازخورد در قالب پاداش یا تنبیه، یاد می گیرد.

یکی از جذابترین جنبههای یادگیری ماشینی RL، کاربردهای گسترده آن در سناریوهای دنیای واقعی است.

از روباتیک تا امور مالی، RL ثابت کرده است که یک ابزار ارزشمند برای حل مشکلات پیچیده و بهینه سازی فرآیندهای تصمیم گیری است.

در زمینه رباتیک، یادگیری ماشینی RL برای آموزش روباتها برای انجام وظایفی که برنامهنویسی صریح آن دشوار است، استفاده شده است.

به عنوان مثال، محققان با موفقیت روباتهایی را آموزش دادهاند تا راه بروند، اشیا را دستکاری کنند و حتی بازیهایی مانند شطرنج و برو انجام دهند.

با اجازه دادن به روباتها برای یادگیری از تجربیات خود، RL آنها را قادر میسازد تا با محیطهای مختلف سازگار شوند و عملکرد خود را در طول زمان بهبود بخشند.

در صنعت مراقبت های بهداشتی، یادگیری ماشینی RL این پتانسیل را دارد که مراقبت از بیمار را متحول کند.

به عنوان مثال، الگوریتمهای RL را میتوان برای بهینهسازی طرحهای درمانی برای بیماران مبتلا به بیماریهای مزمن استفاده کرد.

با یادگیری مداوم از داده ها و بازخورد بیمار، این الگوریتم ها می توانند استراتژی های درمانی را برای به حداکثر رساندن نتایج بیمار تطبیق دهند.

علاوه بر این، RL را می توان برای توسعه پزشکی شخصی مورد استفاده قرار داد، جایی که تصمیمات درمانی بر اساس ویژگی های منحصر به فرد بیماران و پاسخ به درمان های قبلی تنظیم می شود.

حوزه دیگری که یادگیری ماشین RL در آن تأثیر قابل توجهی دارد، امور مالی است.

الگوریتم های RL را می توان برای بهینه سازی استراتژی های معاملاتی و مدیریت پورتفولیو استفاده کرد.

این الگوریتمها با یادگیری از دادهها و بازخوردهای تاریخی بازار، میتوانند الگوها و روندهایی را که انسانها ممکن است نادیده بگیرند، شناسایی کنند.

این می تواند منجر به تصمیمات تجاری سودآورتر و مدیریت ریسک بهتر شود.

در صنعت حمل و نقل، یادگیری ماشینی RL برای بهبود مدیریت ترافیک و سیستمهای رانندگی مستقل استفاده میشود.

الگوریتمهای RL میتوانند کنترل سیگنالهای ترافیکی را در زمان واقعی، بهینهسازی جریان ترافیک و کاهش ازدحام بیاموزند.

علاوه بر این، RL می تواند برای آموزش وسایل نقلیه خودران برای هدایت شرایط پیچیده جاده و تصمیم گیری ایمن در رانندگی استفاده شود.

در زمینه انرژی، یادگیری ماشینی RL برای بهینه سازی مصرف انرژی و کاهش هزینه ها استفاده می شود.

به عنوان مثال، الگوریتمهای RL میتوانند کنترل سیستمهای گرمایش، تهویه و تهویه مطبوع (HVAC) در ساختمانها را یاد بگیرند و با حفظ آسایش ساکنین، کارایی انرژی را به حداکثر برسانند.

RL همچنین می تواند برای بهینه سازی عملکرد شبکه های برق، متعادل کردن عرضه و تقاضا برای به حداقل رساندن هزینه ها و کاهش اثرات زیست محیطی استفاده شود.

به طور کلی، یادگیری ماشینی RL طیف وسیعی از کاربردها در سناریوهای دنیای واقعی دارد.

از روباتیک گرفته تا امور مالی، مراقبت های بهداشتی تا حمل و نقل و انرژی تا بازی، RL راه حل مشکلات پیچیده و تصمیم گیری را متحول می کند.

با اجازه دادن به عوامل برای یادگیری از تجربیات خود، RL آنها را قادر می سازد تا با گذشت زمان سازگار شوند و بهبود یابند.

با ادامه پیشرفت فناوری، میتوان انتظار داشت که در آینده شاهد کاربردهای هیجانانگیزتری از یادگیری ماشینی RL باشیم.

چالشها و محدودیتهای RL یادگیری ماشینی

یادگیری ماشینی (RL) یک زمینه هیجان انگیز است که در سال های اخیر توجه زیادی را به خود جلب کرده است.

این نوعی یادگیری ماشینی است که در آن یک عامل یاد میگیرد با تعامل با محیط و دریافت بازخورد به شکل پاداش یا تنبیه تصمیمگیری کند.

در حالی که RL در برنامه های مختلف نویدهای زیادی را نشان داده است، اما با چالش ها و محدودیت هایی نیز همراه است.

یکی از چالش های اصلی RL، مبادله اکتشاف و بهره برداری است.

به منظور یادگیری سیاست های بهینه، یک عامل RL نیاز به بررسی اقدامات مختلف و پیامدهای آنها دارد.

با این حال، همچنین باید از دانشی که قبلاً به دست آورده است برای به حداکثر رساندن پاداش خود استفاده کند.

ایجاد تعادل مناسب بین اکتشاف و بهره برداری کار دشواری است، زیرا اکتشاف بیش از حد می تواند منجر به یادگیری ناکارآمد شود، در حالی که بهره برداری بیش از حد می تواند منجر به گیرکردن عامل در سیاست های غیربهینه شود.

چالش دیگر RL، نفرین ابعاد است. الگوریتم های RL اغلب در مواجهه با فضاهای حالت و عمل با ابعاد بالا با مشکل مواجه می شوند.

با افزایش تعداد حالتها و اقدامات ممکن، عامل نیاز به کشف فضای جستجوی بزرگتری دارد که میتواند از نظر محاسباتی گران و زمانبر باشد.

این نفرین ابعاد، RL را برای مشکلات دنیای واقعی با محیط های پیچیده کمتر کاربردی می کند.

علاوه بر این، الگوریتمهای RL معمولاً به تعداد زیادی تعامل با محیط برای یادگیری سیاستهای مؤثر نیاز دارند.

این می تواند در سناریوهایی که تعاملات پرهزینه یا وقت گیر هستند محدودیت باشد.

به عنوان مثال، در برنامه های روباتیک، آموزش یک عامل RL برای انجام وظایف پیچیده ممکن است به هزاران یا حتی میلیون ها تعامل نیاز داشته باشد که می تواند در تنظیمات دنیای واقعی غیرعملی یا حتی خطرناک باشد.

یکی دیگر از محدودیت های RL مسئله کارایی نمونه است.

الگوریتم های RL اغلب به مقدار قابل توجهی داده برای یادگیری سیاست های موثر نیاز دارند.

این می تواند در شرایطی که جمع آوری داده ها گران یا محدود است مشکل ساز باشد.

به عنوان مثال، در برنامه های مراقبت های بهداشتی، جمع آوری داده ها از بیماران می تواند چالش برانگیز و زمان بر باشد.

بهبود کارایی نمونه یک حوزه تحقیقاتی فعال در RL است، با هدف توانمندسازی عوامل برای یادگیری از تعاملات کمتر با محیط.

علاوه بر این، الگوریتمهای RL میتوانند به انتخاب فراپارامترها و شرایط اولیه حساس باشند.

تغییرات کوچک در این تنظیمات می تواند به تفاوت های قابل توجهی در سیاست های آموخته شده منجر شود.

این حساسیت میتواند الگوریتمهای RL را قویتر و سختتر کند تا در برنامههای کاربردی دنیای واقعی، جایی که محیط ممکن است پویا و غیرقابل پیشبینی باشد، استقرار یابد.

با وجود این چالش ها و محدودیت ها، یادگیری ماشینی RL در سال های اخیر پیشرفت های چشمگیری داشته است.

محققان فعالانه روی توسعه الگوریتمها و تکنیکهای جدید برای رسیدگی به این مسائل کار میکنند.

با بهبود استراتژیهای اکتشاف، کاهش نفرین ابعاد، افزایش کارایی نمونه، و افزایش استحکام، RL پتانسیل ایجاد انقلابی در حوزههای مختلف از جمله رباتیک، مراقبتهای بهداشتی، مالی و موارد دیگر را دارد.

در نتیجه، در حالی که یادگیری ماشینی RL نویدبخش است، با چالش ها و محدودیت های متعددی نیز مواجه است.

ایجاد تعادل مناسب بین اکتشاف و بهره برداری، مقابله با نفرین ابعاد، بهبود کارایی نمونه، و پرداختن به حساسیت به فراپارامترها و شرایط اولیه برخی از زمینه های کلیدی مورد توجه محققان است.

غلبه بر این چالش ها راه را برای پذیرش گسترده RL در برنامه های کاربردی دنیای واقعی هموار می کند و ماشین ها را قادر می سازد در محیط های پیچیده یاد بگیرند و تصمیم بگیرند.

روندها و تحولات آینده در یادگیری ماشینی RL

یادگیری ماشین RL چیست؟

در سالهای اخیر، یادگیری ماشینی به یک کلمه کلیدی در صنعت فناوری تبدیل شده است.

از ماشین های خودران گرفته تا دستیاران مجازی، الگوریتم های یادگیری ماشینی طیف گسترده ای از برنامه ها را تقویت می کنند.

یکی از حوزههای خاص یادگیری ماشینی که توجه زیادی را به خود جلب کرده است، یادگیری تقویتی (RL) است.

RL نوعی از یادگیری ماشینی است که بر آموزش یک عامل برای تصمیم گیری در یک محیط برای به حداکثر رساندن پاداش تمرکز دارد.

بنابراین، یادگیری ماشین RL دقیقاً چیست؟ در هسته خود، RL در مورد یادگیری از تعامل با یک محیط است.

عامل که می تواند یک برنامه کامپیوتری یا یک ربات باشد، اقداماتی را در محیط انجام می دهد و بازخوردهایی را به صورت پاداش یا جریمه دریافت می کند.

هدف عامل یادگیری یک خط مشی، مجموعه ای از قوانین یا اقدامات است که پاداش تجمعی را در طول زمان به حداکثر می رساند.

برای درک بهتر RL، اجازه دهید یک مثال را در نظر بگیریم. رباتی را تصور کنید که یاد می گیرد در پیچ و خم حرکت کند.

در ابتدا، ربات هیچ اطلاعی از پیچ و خم یا نحوه هدایت آن ندارد. با انجام اقدامات تصادفی شروع می شود و بر اساس عملکرد خود بازخورد دریافت می کند.

اگر ربات به هدف برسد، پاداش مثبت دریافت می کند. در غیر این صورت، پاداش منفی دریافت می کند.

با گذشت زمان، ربات یاد می گیرد که کدام اقدامات منجر به پاداش مثبت می شود و سیاست خود را بر اساس آن تنظیم می کند.

از طریق آزمون و خطا، ربات به تدریج عملکرد خود را بهبود می بخشد و در جهت یابی در پیچ و خم کارآمدتر می شود.

یکی از جنبه های کلیدی RL، مبادله اکتشاف و بهره برداری است.

در مراحل اولیه یادگیری، عامل نیاز به بررسی اقدامات مختلف برای کشف بهترین استراتژی دارد. با این حال، همانطور که دانش بیشتری به دست می آورد، باید از سیاست های آموخته شده برای به حداکثر رساندن پاداش ها استفاده کند.

ایجاد تعادل مناسب بین اکتشاف و بهره برداری برای دستیابی به عملکرد بهینه بسیار مهم است.

RL با موفقیت در حوزه های مختلف، از جمله روباتیک، بازی کردن، و سیستم های توصیه اعمال شده است.

در رباتیک، RL برای آموزش به روبات ها برای انجام کارهای پیچیده مانند گرفتن اشیا یا راه رفتن استفاده شده است.

با اجازه دادن به ربات ها برای یادگیری از تجربیات خود، RL آنها را قادر می سازد تا با محیط های مختلف سازگار شوند و موقعیت های پیش بینی نشده را مدیریت کنند.

در دنیای بازی، RL پیشرفت های چشمگیری داشته است. برای مثال AlphaGo شرکت DeepMind از تکنیک های RL برای شکست دادن بازیکنان قهرمان جهان Go استفاده کرد.

AlphaGo با انجام میلیون ها بازی علیه خود، یاد گرفت که حرکات استراتژیک انجام دهد و از حریفان خود پیشی بگیرد.

این پیشرفت، قدرت RL را در مقابله با مشکلات پیچیده نشان داد و علاقه به کاربردهای بالقوه آن را برانگیخت.

حوزه دیگری که RL در آن مورد توجه قرار گرفته است، سیستم های توصیه است. شرکت هایی مانند نتفلیکس و آمازون از الگوریتم های RL برای شخصی سازی توصیه ها برای کاربران خود استفاده می کنند.

با یادگیری از تعاملات گذشته کاربران، این الگوریتمها میتوانند فیلمها، محصولات یا مقالاتی را پیشنهاد کنند که احتمالاً مورد علاقه کاربر هستند.

این نه تنها تجربه کاربر را بهبود می بخشد، بلکه به کسب و کارها کمک می کند تا تعامل و فروش مشتری را افزایش دهند.

با نگاهی به آینده، آینده یادگیری ماشین RL امیدوارکننده به نظر می رسد.

محققان به طور مداوم در حال بررسی الگوریتم ها و تکنیک های جدید برای بهبود عملکرد و کارایی سیستم های RL هستند.

Deep RL که یادگیری عمیق را با RL ترکیب می کند، پتانسیل زیادی در حل مسائل پیچیده نشان داده است. با استفاده از قدرت شبکههای عصبی، الگوریتمهای RL عمیق میتوانند مستقیماً از ورودیهای حسی خام بیاموزند و عوامل را قادر میسازند تا تصمیمات آگاهانهتری بگیرند.

علاوه بر این، انتظار می رود RL نقش مهمی در توسعه سیستم های خودمختار ایفا کند.

از ماشینهای خودران گرفته تا روباتهای هوشمند، RL میتواند این سیستمها را قادر میسازد تا از تجربیات خود بیاموزند و با محیطهای در حال تغییر سازگار شوند. این نه تنها عملکرد آنها را افزایش می دهد بلکه آنها را قابل اعتمادتر و ایمن تر می کند.

در نتیجه، یادگیری ماشینی RL یک رویکرد قدرتمند است که به عوامل اجازه می دهد تا از تعاملات با یک محیط برای به حداکثر رساندن پاداش ها بیاموزند. این با موفقیت در حوزه های مختلف اعمال شده است و پتانسیل زیادی برای پیشرفت های آینده دارد.

از آنجایی که محققان به دنبال کردن مرزهای RL ادامه میدهند، میتوان انتظار داشت که برنامهها و پیشرفتهای هیجانانگیزی در این زمینه ببینیم. بنابراین، همچنان مراقب یادگیری ماشینی RL باشید تا آینده فناوری را شکل دهد.

منبع » آکادمی اشکان مستوفی