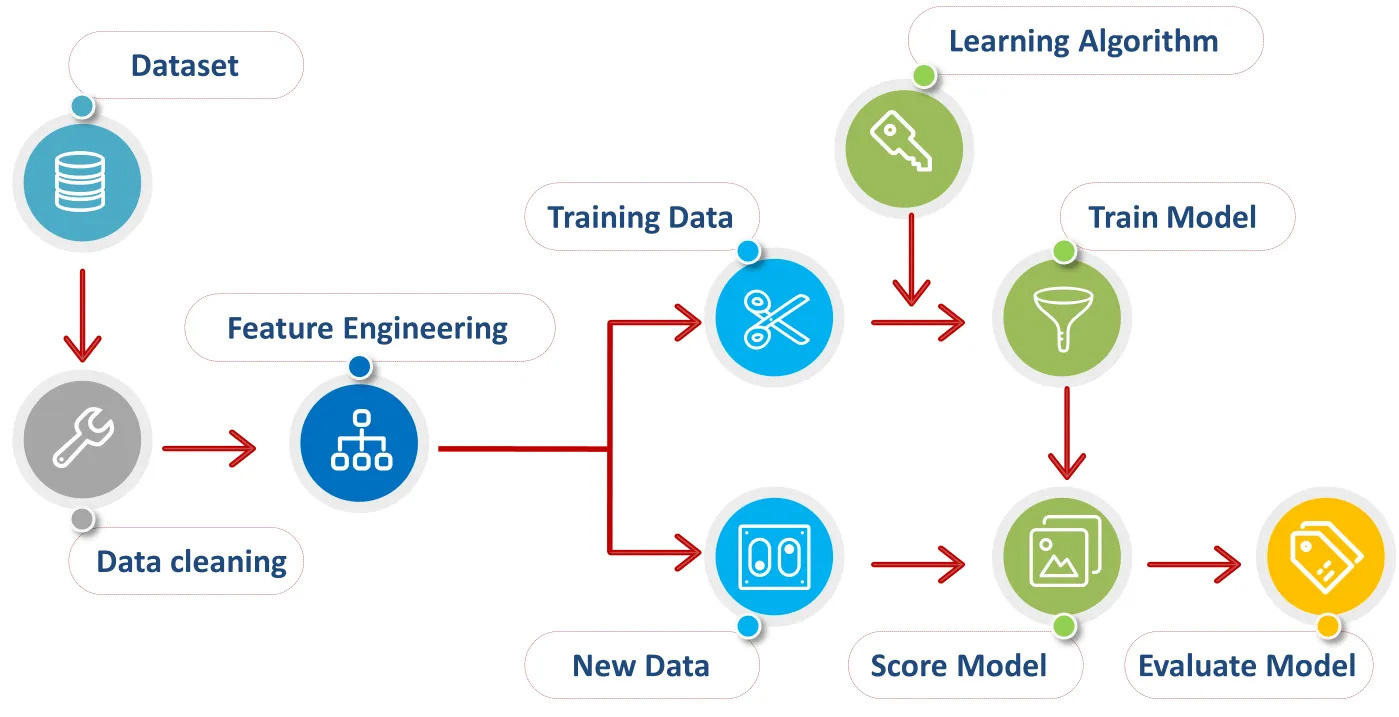

پیش پردازش داده ها گامی مهم در یادگیری ماشینی است که شامل تبدیل داده های خام به قالب است. که برای تحلیل مناسب است اغلب گفته می شود که کیفیت داده های ورودی، کیفیت خروجی تولید شده توسط یک مدل یادگیری ماشین را تعیین می کند.

بنابراین، پیش پردازش داده ها نقش حیاتی در حصول اطمینان از نتایج دقیق و قابل اعتماد ایفا می کند.

یکی از دلایل اصلی اهمیت پیش پردازش داده ها در یادگیری ماشین این است که داده های دنیای واقعی اغلب نامرتب و ناسازگار هستند.

ممکن است حاوی مقادیر گمشده، نقاط دورافتاده یا خطاهایی باشد که میتواند بر عملکرد یک مدل یادگیری ماشین تأثیر منفی بگذارد.

اهمیت پیش پردازش داده ها در یادگیری ماشینی

با پیش پردازش داده ها می توان به این مسائل رسیدگی کرد و داده ها را تمیز و استاندارد کرد.

مقادیر از دست رفته یک مشکل رایج در مجموعه داده های دنیای واقعی است.

آنها می توانند به دلایل مختلفی مانند خطای انسانی یا مسائل فنی در هنگام جمع آوری داده ها رخ دهند.

اگر مقادیر از دست رفته به درستی مدیریت نشوند، می توانند منجر به نتایج مغرضانه یا نادرست شوند.

تکنیکهای پیشپردازش دادهها، مانند تلقین، میتواند برای پر کردن مقادیر گمشده با مقادیر تخمین زده شده بر اساس دادههای موجود استفاده شود.

این کمک می کند تا اطمینان حاصل شود که داده ها کامل و آماده برای تجزیه و تحلیل هستند.

موارد پرت یکی دیگر از مسائلی است که می تواند بر عملکرد یک مدل یادگیری ماشین تأثیر بگذارد.

نقاط پرت نقاط داده ای هستند که به طور قابل توجهی از بقیه داده ها انحراف دارند.

آنها می توانند ناشی از خطاهای اندازه گیری یا رویدادهای نادر باشند.

نقاط دورافتاده می توانند تأثیر نامتناسبی بر نتایج یک مدل یادگیری ماشین داشته باشند، زیرا می توانند داده ها را منحرف کنند و منجر به پیش بینی های نادرست شوند.

تکنیکهای پیشپردازش دادهها، مانند تشخیص و حذف موارد پرت، میتواند برای شناسایی و مدیریت مناسب موارد پرت استفاده شود.

پیش پردازش داده ها علاوه بر مقادیر و مقادیر پرت از دست رفته، شامل استانداردسازی داده ها نیز می شود.

استانداردسازی فرآیند تبدیل داده ها به گونه ای است که میانگین آن صفر و انحراف معیار یک باشد.

این مهم است زیرا الگوریتم های یادگیری ماشین اغلب فرض می کنند که داده های ورودی به طور معمول توزیع شده و مقیاس مشابهی دارند.

با استانداردسازی داده ها، الگوریتم می تواند موثرتر کار کند و نتایج دقیق تری تولید کند.

دلیل دیگری که چرا پیش پردازش داده در یادگیری ماشین اهمیت دارد این است که به کاهش پیچیدگی داده ها کمک می کند.

مجموعه داده های دنیای واقعی می توانند بزرگ و پیچیده باشند، با متغیرها و ویژگی های متعدد.

برخی از این متغیرها ممکن است نامربوط یا زائد باشند که میتواند منجر به تطبیق بیش از حد و تعمیم ضعیف مدل شود.

تکنیکهای پیشپردازش دادهها، مانند انتخاب ویژگی و کاهش ابعاد، میتواند برای شناسایی و حذف متغیرهای نامربوط یا زائد، سادهسازی دادهها و بهبود عملکرد مدل استفاده شود.

در نتیجه، پیش پردازش داده ها یک مرحله مهم در یادگیری ماشینی است که شامل تمیز کردن، تبدیل و استانداردسازی داده های خام برای مناسب ساختن آن برای تجزیه و تحلیل است.

این مهم است زیرا داده های دنیای واقعی اغلب نامرتب و ناسازگار هستند و پیش پردازش به حل مسائلی مانند مقادیر از دست رفته، نقاط پرت و متغیرهای نامربوط کمک می کند.

با پیش پردازش داده ها، مدل های یادگیری ماشینی می توانند نتایج دقیق و قابل اطمینان تری تولید کنند.

بنابراین، قبل از فرو رفتن در تجزیه و تحلیل، سرمایه گذاری زمان و تلاش برای پیش پردازش داده ها برای اطمینان از کیفیت و یکپارچگی داده ها ضروری است.

تکنیک های رایج برای پیش پردازش داده ها

پیش پردازش داده ها یک مرحله ضروری در فرآیند تجزیه و تحلیل داده ها است.

این شامل تبدیل داده های خام به قالبی است که برای تجزیه و تحلیل مناسب است.

با پاکسازی و سازماندهی داده ها، محققان می توانند از دقیق و قابل اعتماد بودن یافته هایشان اطمینان حاصل کنند.

در این بخش، برخی از تکنیک های رایج مورد استفاده در پیش پردازش داده ها را بررسی خواهیم کرد.

یکی از اولین مراحل در پیش پردازش داده ها، پاکسازی داده ها است.

این شامل حذف هر گونه خطا یا ناهماهنگی در داده ها است.

به عنوان مثال، اگر یک مجموعه داده حاوی مقادیر گم شده باشد، محققان ممکن است انتخاب کنند یا آن ردیف ها را حذف کنند یا مقادیر از دست رفته را با تخمین مناسب پر کنند.

با انجام این کار، آنها می توانند از نتایج مغرضانه اجتناب کنند و اطمینان حاصل کنند که تجزیه و تحلیل آنها بر اساس داده های کامل و دقیق است.

یکی دیگر از تکنیک های مورد استفاده در پیش پردازش داده ها، تبدیل داده ها است.

این شامل تبدیل داده ها به قالب مناسب تری برای تجزیه و تحلیل است.

به عنوان مثال، اگر داده ها به طور معمول توزیع نشده باشند، محققان ممکن است تغییری مانند تبدیل لگاریتمی یا ریشه دوم را برای مطابقت با مفروضات تحلیل خود اعمال کنند.

با تبدیل داده ها، محققان می توانند دقت نتایج خود را بهبود بخشند و آنها را قابل تفسیرتر کنند.

نرمال سازی داده ها یکی دیگر از تکنیک های مهم در پیش پردازش داده ها است.

این شامل مقیاس بندی داده ها به گونه ای است که در محدوده خاصی قرار می گیرند.

این امر به ویژه در هنگام برخورد با متغیرهایی که واحدهای اندازه گیری متفاوتی دارند مفید است.

با نرمالسازی دادهها، محققین میتوانند اطمینان حاصل کنند که هر متغیر به طور مساوی در تجزیه و تحلیل مشارکت دارد و از تسلط هر متغیری بر نتایج جلوگیری میکند.

مدیریت متغیرهای طبقه بندی شده نیز یکی از جنبه های مهم پیش پردازش داده ها است.

متغیرهای طبقه بندی متغیرهایی هستند که مقادیر مجزایی مانند جنسیت یا شغل به خود می گیرند.

به منظور گنجاندن این متغیرها در تحلیل، محققین باید آنها را به قالب عددی تبدیل کنند.

این را می توان از طریق فرآیندی به نام رمزگذاری یک داغ انجام داد، که در آن هر دسته با یک متغیر باینری نشان داده می شود.

با انجام این کار، محققان می توانند متغیرهای طبقه بندی شده را بدون ارائه هرگونه سوگیری در تحلیل خود بگنجانند.

تکنیک های کاهش داده نیز معمولاً در پیش پردازش داده ها استفاده می شود.

هدف این تکنیک ها کاهش ابعاد داده ها با انتخاب زیرمجموعه ای از متغیرهای مرتبط است.

این امر به ویژه هنگام برخورد با مجموعه داده هایی که دارای تعداد زیادی متغیر هستند مفید است، زیرا می تواند به ساده سازی تحلیل و بهبود کارایی محاسباتی کمک کند.

تکنیک هایی مانند تجزیه و تحلیل مؤلفه اصلی (PCA) و الگوریتم های انتخاب ویژگی را می توان برای شناسایی مهم ترین متغیرها در مجموعه داده استفاده کرد.

در نتیجه، پیش پردازش داده ها یک مرحله مهم در فرآیند تجزیه و تحلیل داده ها است.

با تمیز کردن، تبدیل، عادی سازی و مدیریت متغیرهای طبقه بندی شده، محققان می توانند اطمینان حاصل کنند که تجزیه و تحلیل آنها بر اساس داده های دقیق و قابل اعتماد است.

علاوه بر این، تکنیکهای کاهش دادهها میتوانند به سادهسازی تحلیل و بهبود کارایی محاسباتی کمک کنند.

با استفاده از این تکنیکهای رایج، محققان میتوانند بینشهای معناداری را از دادههای خود به دست آورند و تصمیمات آگاهانه بگیرند.

تحلیل دادههای اکتشافی: مرحله کلیدی در پیش پردازش داده ها

یکی از مراحل کلیدی در پیش پردازش داده ها، تجزیه و تحلیل داده های اکتشافی (EDA) است.

EDA به درک داده ها و شناسایی الگوها یا روندهایی که ممکن است وجود داشته باشد کمک می کند.

تجزیه و تحلیل داده های اکتشافی همه چیز در مورد شناخت داده های شما است.

این شامل بررسی داده ها از زوایای مختلف و دیدگاه های مختلف برای به دست آوردن بینش و تصمیم گیری آگاهانه است.

EDA به کشف هر گونه ناهنجاری یا پرت در داده ها کمک می کند، که می تواند برای تمیز کردن و پیش پردازش داده ها مهم باشد.

در طول EDA، تکنیکها و تجسمهای آماری مختلفی برای کشف دادهها استفاده میشود.

آمار توصیفی مانند میانگین، میانه و انحراف معیار، خلاصه ای از داده ها را ارائه می دهد.

این آمار به درک گرایش مرکزی و پراکندگی داده ها کمک می کند.

تجسم ها، مانند هیستوگرام، نمودار پراکندگی، و نمودار جعبه، نیز در EDA استفاده می شود.

این تجسم ها نمایشی گرافیکی از داده ها را ارائه می دهند و شناسایی الگوها یا روابط را آسان تر می کنند.

به عنوان مثال، نمودار پراکندگی می تواند رابطه بین دو متغیر را نشان دهد، در حالی که نمودار جعبه می تواند توزیع یک متغیر را نشان دهد.

EDA همچنین شامل بررسی مقادیر از دست رفته در داده ها می شود.

مقادیر از دست رفته ممکن است به دلایل مختلفی مانند خطاهای ورود داده یا داده های ناقص رخ دهد.

مهم است که مقادیر از دست رفته را به طور مناسب شناسایی و مدیریت کنید، زیرا می توانند بر دقت و قابلیت اطمینان تجزیه و تحلیل تأثیر بگذارند.

برای رسیدگی به مقادیر گمشده می توان از تکنیک هایی مانند انتساب یا حذف استفاده کرد.

یکی دیگر از جنبه های مهم EDA، شناسایی و رسیدگی به موارد پرت است.

نقاط پرت نقاط داده ای هستند که به طور قابل توجهی از بقیه داده ها انحراف دارند.

آنها می توانند ناشی از خطاهای اندازه گیری باشند یا مقادیر شدید را نشان دهند.

نقاط دورافتاده می توانند تأثیر قابل توجهی بر تجزیه و تحلیل داشته باشند، بنابراین مهم است که آنها را به طور مناسب شناسایی و مدیریت کنید.

تکنیک هایی مانند برش زدن یا پیرایش را می توان برای رسیدگی به موارد پرت استفاده کرد.

EDA همچنین شامل بررسی توزیع متغیرها می شود.

درک توزیع متغیرها برای انتخاب تکنیک ها و مدل های آماری مناسب مهم است.

به عنوان مثال، اگر یک متغیر به طور معمول توزیع شده باشد، می توان از آزمون های آماری پارامتریک استفاده کرد.

از سوی دیگر، اگر متغیری به طور معمول توزیع نشده باشد، آزمون های ناپارامتریک ممکن است مناسب تر باشند.

علاوه بر این تکنیک ها، EDA همچنین شامل بررسی روابط بین متغیرها می شود.

این را می توان از طریق تحلیل همبستگی یا تحلیل رگرسیون انجام داد.

تحلیل همبستگی به درک قدرت و جهت رابطه بین دو متغیر کمک می کند.

تحلیل رگرسیون به مدل سازی رابطه بین یک متغیر وابسته و یک یا چند متغیر مستقل کمک می کند.

به طور کلی، تجزیه و تحلیل داده های اکتشافی یک مرحله کلیدی در پیش پردازش داده ها است.

به درک داده ها، شناسایی هر گونه الگو یا روند و تصمیم گیری آگاهانه کمک می کند.

EDA شامل تکنیک های آماری و تجسم های مختلف برای کشف داده ها می شود.

همچنین شامل رسیدگی به مقادیر گمشده، پرت و بررسی توزیع و روابط بین متغیرها می شود.

با انجام کامل EDA، محققان می توانند اطمینان حاصل کنند که داده های آنها برای تجزیه و تحلیل و تفسیر بیشتر آماده است.

Handling داده های گمشده در پیش پردازش داده ها

داده ها پیش پردازش یک مرحله اساسی در فرآیند تجزیه و تحلیل داده ها است.

این شامل تبدیل داده های خام به قالبی است که برای تجزیه و تحلیل مناسب است.

یکی از مشکلات رایجی که در طول پیش پردازش داده ها ایجاد می شود، داده های از دست رفته است.

داده های از دست رفته به عدم وجود مقادیر در یک مجموعه داده اشاره دارد که می تواند به دلایل مختلفی مانند خطاهای وارد کردن داده ها، عملکرد نادرست تجهیزات یا عدم پاسخگویی شرکت کننده رخ دهد.

مدیریت داده های از دست رفته بسیار مهم است زیرا می تواند تأثیر قابل توجهی بر نتایج تجزیه و تحلیل داده ها داشته باشد.

نادیده گرفتن داده های از دست رفته یا صرفاً حذف مشاهدات با مقادیر از دست رفته می تواند منجر به نتیجه گیری های مغرضانه و نادرست شود.

بنابراین، استفاده از تکنیک های مناسب برای مدیریت موثر داده های از دست رفته بسیار مهم است.

یکی از روش های رایج برای مدیریت داده های از دست رفته حذف است.

این شامل حذف مشاهدات با مقادیر گمشده از مجموعه داده است.

دو نوع اصلی حذف وجود دارد: حذف لیستی و حذف زوجی.

حذف لیستی، که به عنوان تجزیه و تحلیل کامل مورد نیز شناخته می شود، شامل حذف کل مشاهداتی است که مقادیر گمشده دارند.

از سوی دیگر، حذف زوجی شامل تنها استفاده از داده های موجود برای هر تجزیه و تحلیل است، به این معنی که تحلیل های مختلف ممکن است از زیر مجموعه های متفاوتی از داده ها استفاده کنند.

اگرچه ممکن است حذف یک راه حل ساده به نظر برسد، اما محدودیت هایی دارد.

با حذف مشاهدات با مقادیر از دست رفته، ممکن است اطلاعات ارزشمند از بین برود، و نمایندگی داده های باقی مانده ممکن است به خطر بیفتد.

بهعلاوه، اگر دادههای از دست رفته تصادفی نباشند، حذف میتواند سوگیری را وارد تحلیل کند.

بنابراین، حذف باید با احتیاط و تنها زمانی مورد استفاده قرار گیرد که داده های از دست رفته اندک باشد و بعید است که بر تجزیه و تحلیل کلی تأثیر بگذارد.

روش دیگر برای رسیدگی به داده های از دست رفته، تلقین است.

انتساب شامل تخمین مقادیر از دست رفته بر اساس داده های موجود است.

روشهای انتساب مختلفی وجود دارد، از جمله انتساب میانگین، انتساب میانه و انتساب رگرسیون.

میانگین انتساب مقادیر از دست رفته را با میانگین مقادیر موجود برای آن متغیر جایگزین می کند.

به طور مشابه، انتساب میانه مقادیر از دست رفته را با میانه مقادیر موجود جایگزین می کند.

از سوی دیگر، انتساب رگرسیون شامل پیشبینی مقادیر گمشده بر اساس رابطه بین متغیر با مقادیر گمشده و سایر متغیرهای مجموعه داده است.

Imputation می تواند یک تکنیک مفید برای مدیریت داده های از دست رفته باشد، زیرا امکان حفظ تمام مشاهدات در تجزیه و تحلیل را فراهم می کند.

با این حال، توجه به این نکته مهم است که مقادیر نسبت داده شده تخمینی هستند و ممکن است سطحی از خطا را در تحلیل وارد کنند.

انتخاب روش انتساب باید بر اساس ویژگی های داده ها و سؤال تحقیق مورد نظر باشد.

علاوه بر حذف و انتساب، تکنیک های پیشرفته دیگری نیز برای مدیریت داده های از دست رفته وجود دارد، مانند انتساب چندگانه و تخمین حداکثر احتمال.

انتساب چندگانه شامل ایجاد مجموعه داده های منتسب متعدد و ترکیب نتایج برای به دست آوردن تخمین های دقیق تر است.

از سوی دیگر، برآورد حداکثر احتمال شامل تخمین مقادیر گمشده بر اساس احتمال داده های مشاهده شده است.

در نتیجه، رسیدگی به داده های از دست رفته گامی مهم در پیش پردازش داده است.

حذف و انتساب دو رویکرد رایج برای مدیریت داده های از دست رفته هستند که هر کدام مزایا و محدودیت های خاص خود را دارند.

حذف باید با احتیاط مورد استفاده قرار گیرد، زیرا می تواند منجر به نتایج مغرضانه و از دست دادن اطلاعات ارزشمند شود.

از سوی دیگر، انتساب، امکان حفظ همه مشاهدات را فراهم می کند، اما سطحی از خطا را معرفی می کند.

تکنیکهای پیشرفتهای مانند انتساب چندگانه و تخمین حداکثر احتمال نیز میتوانند برای مدیریت دقیقتر دادههای از دست رفته استفاده شوند.

در نهایت، انتخاب روش باید بر اساس ویژگیهای دادهها و سؤال تحقیق در دست باشد.

مقیاسسازی ویژگی و عادیسازی دادهها پیش پردازش

پیش پردازش داده یک مرحله ضروری در هر پروژه تجزیه و تحلیل داده یا یادگیری ماشینی است.

این شامل تبدیل داده های خام به قالبی است که برای تجزیه و تحلیل بیشتر مناسب است.

یکی از جنبه های مهم پیش پردازش داده ها مقیاس بندی و عادی سازی ویژگی ها است.

مقیاس بندی ویژگی فرآیند تبدیل مقادیر ویژگی های مختلف در یک مجموعه داده به یک مقیاس مشترک است.

این امر ضروری است زیرا ویژگی ها اغلب واحدها یا محدوده های متفاوتی دارند که می تواند برای الگوریتم های خاصی مشکل ایجاد کند.

به عنوان مثال، اگر یک ویژگی دارای مقادیری در محدوده 0-100 و ویژگی دیگری دارای مقادیر در محدوده 0-1000 باشد، الگوریتم ممکن است به ویژگی با مقادیر بزرگتر اهمیت بیشتری بدهد.

روشهای مختلفی برای مقیاسبندی ویژگیها وجود دارد، اما یک رویکرد رایج، مقیاسبندی حداقل حداکثر نام دارد.

در این روش، هر ویژگی به محدوده ای بین 0 و 1 تبدیل می شود.

فرمول مقیاس بندی حداقل حداکثر به صورت زیر است:

scaled_value = (value – min_value) / (max_value – min_value)

جایی که value مقدار اصلی ویژگی است، min_value حداقل مقدار ویژگی در مجموعه داده است و max_value حداکثر مقدار ویژگی در مجموعه داده است.

این فرمول تضمین می کند که مقادیر تبدیل شده در محدوده مورد نظر قرار دارند.

روش دیگری برای مقیاس بندی ویژگی ها استانداردسازی نام دارد.

در این روش، هر ویژگی تبدیل به میانگین 0 و انحراف معیار 1 می شود.

فرمول استانداردسازی به صورت زیر است:

scaled_value = (مقدار – میانگین) / استاندارد_انحراف

در جایی که value مقدار اصلی ویژگی است، میانگین مقدار میانگین ویژگی در مجموعه داده است، و standard_deviation انحراف استاندارد ویژگی در مجموعه داده است.

استانداردسازی زمانی مفید است که توزیع مقادیر ویژگی مشخص نباشد یا گاوسی نباشد.

عادی سازی یکی دیگر از تکنیک های مهم در پیش پردازش داده ها است.

از آن برای تبدیل کل مجموعه داده استفاده می شود تا هر نمونه دارای یک هنجار واحد باشد.

این بدان معنی است که هنجار اقلیدسی هر نمونه برابر با 1 است.

عادی سازی به ویژه زمانی مفید است که بزرگی ویژگی ها مهم نیست، اما جهت یا زاویه بین نمونه ها مهم است.

روشهای مختلفی برای نرمالسازی وجود دارد، اما یک رویکرد رایج، نرمالسازی L2 نام دارد.

در این روش هر نمونه بر اساس هنجار اقلیدسی خود تقسیم می شود.

فرمول نرمال سازی L2 به صورت زیر است:

normalized_sample = نمونه / هنجار (نمونه)

که در آن نمونه نمونه اصلی است و هنجار(نمونه) هنجار اقلیدسی نمونه است.

این فرمول تضمین می کند که نمونه های تبدیل شده دارای یک هنجار واحد هستند.

مقیاس بندی و عادی سازی ویژگی ها مراحل مهمی در پیش پردازش داده ها هستند زیرا می توانند عملکرد الگوریتم های یادگیری ماشین را بهبود بخشند.

با تبدیل ویژگی ها به یک مقیاس مشترک یا عادی سازی کل مجموعه داده، می توانیم اطمینان حاصل کنیم که الگوریتم به همه ویژگی ها و نمونه ها اهمیت یکسانی می دهد.

این می تواند به جلوگیری از تسلط برخی ویژگی ها بر تجزیه و تحلیل یا سوگیری نتایج کمک کند.

در نتیجه، مقیاسبندی ویژگی و عادیسازی تکنیکهای حیاتی در پیشپردازش دادهها هستند.

آنها به تبدیل داده های خام به قالبی که برای تجزیه و تحلیل بیشتر مناسب است کمک می کنند.

با مقیاس بندی ویژگی ها در یک مقیاس مشترک یا عادی سازی کل مجموعه داده، می توانیم اطمینان حاصل کنیم که الگوریتم های یادگیری ماشین عملکرد بهینه ای دارند و نتایج دقیقی تولید می کنند.

بنابراین، دفعه بعد که یک پروژه تجزیه و تحلیل داده یا یادگیری ماشین را آغاز کردید، فراموش نکنید که داده های خود را از قبل پردازش کنید و تکنیک های مقیاس بندی و نرمال سازی ویژگی ها را به کار ببرید.

منبع » آکادمی اشکان مستوفی