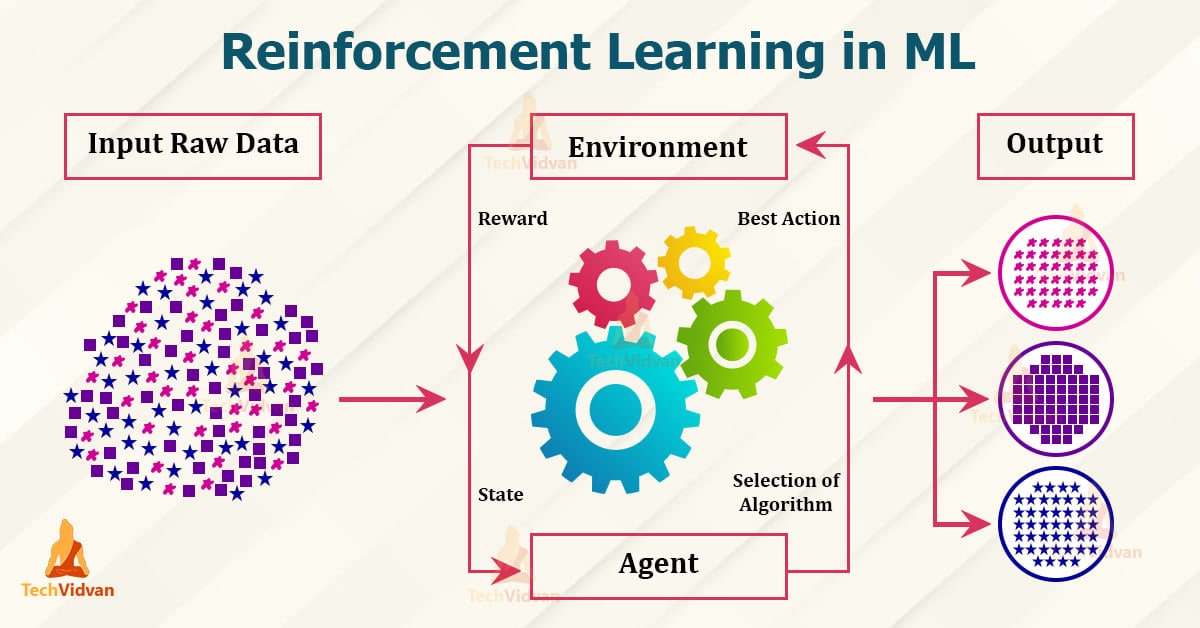

یادگیری تقویتی یا Reinforcement Learning یک رشته مطالعاتی جذاب است که در سال های اخیر توجه قابل توجهی را به خود جلب کرده است. این نوعی از یادگیری ماشینی است که بر آموزش یک عامل برای تصمیم گیری و انجام اقدامات در یک محیط برای به حداکثر رساندن پاداش معین تمرکز می کند.

به عبارت ساده تر، آموزش یک برنامه کامپیوتری برای یادگیری از تجربیات خود و بهبود عملکرد آن در طول زمان است.

در هسته خود، یادگیری تقویتی از روشی که انسان ها و حیوانات از طریق آزمون و خطا یاد می گیرند، الهام گرفته شده است.

درست مانند کودکی که دوچرخه سواری را یاد می گیرد، یک عامل در یادگیری تقویتی بدون دانش قبلی شروع می کند و به تدریج با تعامل با محیط خود یاد می گیرد.

عامل بر اساس اعمال خود بازخوردی را در قالب پاداش یا تنبیه دریافت می کند که به او کمک می کند بفهمد چه اقداماتی مطلوب است و از چه اقداماتی باید اجتناب کرد.

Reinforcement learning

یکی از مفاهیم کلیدی در یادگیری تقویتی، مفهوم محیط است. محیط، دنیای مجازی یا فیزیکی است که عامل در آن فعالیت می کند.

این می تواند به سادگی یک شبکه یا به پیچیدگی شبیه سازی واقعیت مجازی باشد.

عامل با انجام اقداماتی با محیط در تعامل است و محیط با ارائه بازخورد در قالب پاداش یا تنبیه پاسخ می دهد.

هدف از یادگیری تقویتی یافتن یک خط مشی بهینه است که مجموعه قوانینی است که عامل برای به حداکثر رساندن پاداش بلندمدت خود از آنها پیروی می کند.

عامل این خط مشی را با بررسی اقدامات مختلف و مشاهده پاداش های مربوط به هر عمل می آموزد.

با گذشت زمان، یاد می گیرد که برخی از اقدامات را با پاداش های بالاتر مرتبط کند و رفتار خود را بر اساس آن تنظیم می کند.

برای دستیابی به این هدف، الگوریتم های یادگیری تقویتی از تکنیکی به نام تکرار ارزش استفاده می کنند.

تکرار ارزش شامل تخمین ارزش هر حالت در محیط است که نشان دهنده پاداش بلندمدت مورد انتظاری است که عامل می تواند از آن حالت به دست آورد.

با به روز رسانی این تخمین های ارزش بر اساس پاداش های مشاهده شده، عامل می تواند به تدریج روند تصمیم گیری خود را بهبود بخشد.

یکی از جنبه های منحصر به فرد یادگیری تقویتی، مبادله اکتشاف و بهره برداری است.

برای یافتن خط مشی بهینه، عامل نیاز به بررسی اقدامات مختلف و جمع آوری اطلاعات در مورد پاداش آنها دارد.

با این حال، همچنین باید از دانشی که قبلاً به دست آورده است برای به حداکثر رساندن پاداش فوری خود استفاده کند.

ایجاد تعادل مناسب بین اکتشاف و بهره برداری یک کار چالش برانگیز در یادگیری تقویتی است.

یادگیری تقویتی در طیف وسیعی از زمینه ها، از رباتیک گرفته تا امور مالی، کاربرد پیدا کرده است.

در رباتیک، یادگیری تقویتی را می توان برای آموزش ربات ها برای انجام کارهای پیچیده، مانند گرفتن اشیا یا حرکت در پیچ و خم استفاده کرد.

در امور مالی، از یادگیری تقویتی می توان برای توسعه استراتژی های معاملاتی استفاده کرد که سود را در بازارهای پویا به حداکثر می رساند.

در نتیجه، یادگیری تقویتی یک رویکرد قدرتمند برای یادگیری ماشینی است که بر آموزش عوامل برای تصمیم گیری و انجام اقدامات در یک محیط برای به حداکثر رساندن یک پاداش خاص تمرکز دارد.

این الهام از نحوه یادگیری انسان ها و حیوانات از طریق آزمون و خطا است و شامل کاوش در اعمال مختلف و بهره برداری از دانش آموخته شده است.

با طیف گسترده ای از کاربردها، یادگیری تقویتی یک زمینه هیجان انگیز است که نویدهای زیادی برای آینده دارد.

کاربردهای یادگیری تقویتی در سناریوهای دنیای واقعی

یکی از شناخته شده ترین کاربردهای یادگیری تقویتی در زمینه رباتیک است. با استفاده از الگوریتمهای یادگیری تقویتی، رباتها میتوانند کارهای پیچیده را بدون برنامهنویسی صریح انجام دهند.

به عنوان مثال، یک ربات می تواند یاد بگیرد که در یک پیچ و خم حرکت کند یا اشیاء موجود در محیط خود را دستکاری کند.

این توانایی یادگیری از تجربه به ربات ها اجازه می دهد تا با موقعیت های مختلف سازگار شوند و خودمختارتر شوند.

حوزه دیگری که یادگیری تقویتی در آن سهم قابل توجهی داشته است، حوزه مراقبت های بهداشتی است.

تشخیص پزشکی و برنامه ریزی درمان می تواند وظایف پیچیده ای باشد که نیاز به دانش تخصصی دارد.

با استفاده از یادگیری تقویتی، الگوریتم ها می توانند از داده های تاریخی بیمار بیاموزند و در مورد بهترین اقدام پیش بینی کنند. این می تواند به پزشکان در تشخیص دقیق تر و ایجاد برنامه های درمانی شخصی کمک کند.

یادگیری تقویتی در حوزه مالی نیز کاربرد پیدا کرده است. داد و ستد در بازارهای مالی می تواند بسیار غیرقابل پیش بینی باشد و مدل های سنتی اغلب برای به دست آوردن پویایی پیچیده این بازارها تلاش می کنند.

با استفاده از یادگیری تقویتی، الگوریتم ها می توانند تصمیم گیری های معاملاتی را بر اساس داده های تاریخی بازار بیاموزند.

این می تواند به استراتژی های تجاری سودآورتر و مدیریت ریسک بهتر منجر شود.

در زمینه حمل و نقل، یادگیری تقویتی برای توسعه سیستم های هوشمند برای وسایل نقلیه خودران استفاده شده است.

با آموزش الگوریتمها بر روی مجموعه دادههای بزرگ سناریوهای رانندگی، این سیستمها میتوانند تصمیمگیری را در زمان واقعی بیاموزند، مانند زمان تغییر خط یا زمان ترمز کردن.

این می تواند ایمنی و کارایی سیستم های حمل و نقل را بهبود بخشد، تصادفات و ازدحام را کاهش دهد.

یادگیری تقویتی در زمینه مدیریت انرژی نیز کاربردهایی پیدا کرده است.

با استفاده از الگوریتم های یادگیری تقویتی، سیستم های انرژی می توانند عملیات خود را برای به حداقل رساندن هزینه ها و کاهش اثرات زیست محیطی بهینه کنند.

برای مثال، الگوریتمها میتوانند با در نظر گرفتن عواملی مانند قیمت برق و در دسترس بودن انرژی تجدیدپذیر، کنترل شارژ و تخلیه باتریها را در یک شبکه هوشمند کنترل کنند.

در زمینه بازی، از یادگیری تقویتی برای توسعه عوامل هوشمندی استفاده شده است که می توانند بازی ها را در سطح مافوق انسانی انجام دهند.

به عنوان مثال، برنامه AlphaGo که توسط DeepMind توسعه داده شد، توانست قهرمان جهان را در بازی Go شکست دهد که چالش بزرگی برای هوش مصنوعی به حساب می آمد. این دستاورد قدرت یادگیری تقویتی را در حل مسائل پیچیده نشان داد.

در نتیجه، یادگیری تقویتی ابزار قدرتمندی است که در سناریوهای مختلف دنیای واقعی کاربرد پیدا کرده است.

از روباتیک گرفته تا امور مالی، مراقبت های بهداشتی تا حمل و نقل و بازی تا مدیریت انرژی، یادگیری تقویتی صنایع مختلف را متحول می کند.

یادگیری تقویتی با اجازه دادن به عوامل برای یادگیری از تجربه و تصمیم گیری بر اساس آزمون و خطا، ماشین ها را قادر می سازد تا مستقل تر و هوشمندتر شوند.

با ادامه پیشرفت فناوری، میتوان انتظار داشت که در آینده شاهد کاربردهای هیجانانگیزتری از یادگیری تقویتی باشیم.

کاوش در نقش یادگیری عمیق در یادگیری تقویتی

از سوی دیگر، یادگیری عمیق زیرمجموعه ای از یادگیری ماشینی است که از شبکه های عصبی مصنوعی برای مدل سازی و درک الگوهای پیچیده در داده ها استفاده می کند.

در حوزه های مختلف مانند تشخیص تصویر و پردازش زبان طبیعی بسیار موفق بوده است.

الگوریتمهای یادگیری عمیق برای یادگیری خودکار نمایشهای سلسله مراتبی دادهها طراحی شدهاند که به آنها اجازه میدهد تا روابط پیچیده را ثبت کنند و پیشبینیهای دقیق انجام دهند.

بنابراین، نقش یادگیری عمیق در یادگیری تقویتی چیست؟

یادگیری عمیق با قادر ساختن عوامل به یادگیری مستقیم از ورودی حسی خام، مانند تصاویر یا صدا، یادگیری تقویتی را متحول کرده است.

به طور سنتی، الگوریتم های یادگیری تقویتی بر ویژگی های دست ساز متکی بودند، که نیاز به تخصص دامنه داشتند و اغلب برای طراحی زمان بر بودند.

با یادگیری عمیق، عوامل می توانند به طور خودکار ویژگی های مرتبط را از ورودی خام بیاموزند و نیاز به مهندسی ویژگی های دستی را از بین ببرند.

یکی از مزایای کلیدی استفاده از یادگیری عمیق در یادگیری تقویتی، توانایی آن در مدیریت فضاهای حالت با ابعاد بالا و پیوسته است.

در بسیاری از سناریوهای دنیای واقعی، فضای حالت میتواند وسیع باشد، و نمایش و کشف همه حالتهای ممکن را چالش برانگیز میکند.

شبکههای عصبی عمیق میتوانند به طور موثر تابع ارزش یا خط مشی را در چنین محیطهای پیچیدهای تقریب بزنند، و به عوامل اجازه میدهند تا بر اساس وضعیت فعلی تصمیمات آگاهانه بگیرند.

یکی دیگر از جنبه های مهم یادگیری عمیق در یادگیری تقویتی، استفاده از شبکه های عصبی عمیق به عنوان تقریبگر توابع است.

الگوریتمهای یادگیری تقویتی اغلب به تخمین توابع یا خطمشیهای ارزش نیاز دارند که میتواند از نظر محاسباتی گران یا غیرممکن برای فضاهای حالت بزرگ باشد.

شبکههای عصبی عمیق میتوانند به طور موثر این توابع را تقریب بزنند و مقیاسسازی الگوریتمهای یادگیری تقویتی را برای کارهای پیچیدهتر ممکن میسازند.

علاوه بر این، یادگیری عمیق نیز در بهبود کارایی نمونه الگوریتمهای یادگیری تقویتی مؤثر بوده است.

الگوریتم های یادگیری تقویتی سنتی اغلب به تعداد زیادی تعامل با محیط برای یادگیری یک خط مشی بهینه نیاز دارند.

تکنیک های یادگیری عمیق، مانند پخش مجدد تجربه و شبکه های هدف، برای استفاده بهتر از تجربیات گذشته و تسریع در یادگیری معرفی شده اند.

علیرغم مزایای متعدد، یادگیری عمیق در یادگیری تقویتی با چالش هایی نیز همراه است.

شبکه های عصبی عمیق به دلیل تشنه بودن داده ها و مستعد بودن بیش از حد بدنام هستند.

الگوریتم های یادگیری تقویتی که بر یادگیری عمیق متکی هستند، اغلب به مقدار قابل توجهی از داده های آموزشی برای تعمیم خوب نیاز دارند.

علاوه بر این، آموزش شبکههای عصبی عمیق میتواند از نظر محاسباتی گران باشد، بهویژه زمانی که با مشکلات در مقیاس بزرگ سروکار داریم.

در نتیجه، یادگیری عمیق نقش مهمی در پیشبرد یادگیری تقویتی داشته است.

این به عوامل اجازه می دهد تا مستقیماً از ورودی حسی خام یاد بگیرند، فضاهای حالت با ابعاد بالا را مدیریت کنند، توابع یا خط مشی های ارزش پیچیده را تقریبی کنند و کارایی نمونه را بهبود بخشند.

با این حال، چالش هایی مانند الزامات داده و هزینه های محاسباتی را نیز به همراه دارد.

همانطور که یادگیری عمیق به تکامل خود ادامه میدهد، انتظار میرود که قابلیتهای یادگیری تقویتی را بیشتر افزایش دهد و عوامل را قادر میسازد تا حتی با مشکلات پیچیدهتر و واقعیتر مقابله کنند.

الگوریتم های یادگیری تقویتی: یک تحلیل مقایسه ای

یادگیری تقویتی یک زمینه مطالعاتی جذاب است که در سال های اخیر توجه قابل توجهی را به خود جلب کرده است.

این نوعی یادگیری ماشینی است که بر آموزش یک عامل برای تصمیم گیری بر اساس آزمون و خطا تمرکز می کند.

در این مقاله، ما به دنیای الگوریتم های یادگیری تقویتی می پردازیم و تجزیه و تحلیل مقایسه ای برخی از الگوریتم های محبوب ارائه می دهیم.

یکی از شناخته شده ترین الگوریتم های یادگیری تقویتی، یادگیری Q است.

Q-learning یک الگوریتم بدون مدل است که از جدولی به نام Q-table برای ذخیره پاداش های مورد انتظار برای هر عمل در یک وضعیت خاص استفاده می کند.

عامل با انجام اقدامات و به روز رسانی Q-table بر اساس پاداش های مشاهده شده، محیط را کاوش می کند.

با گذشت زمان، عامل سیاست بهینه را با به حداکثر رساندن پاداش تجمعی مورد انتظار میآموزد.

الگوریتم محبوب دیگر Deep Q-Networks (DQN) است. DQN با استفاده از یک شبکه عصبی عمیق برای تقریب مقادیر Q به جای جدول Q، یادگیری Q را به سطح بعدی می برد.

این به DQN اجازه می دهد تا فضاهای حالت با ابعاد بالا را مدیریت کند و آن را برای کارهای پیچیده مناسب می کند.

شبکه عصبی با استفاده از تکنیکی به نام تکرار تجربه آموزش داده می شود، که در آن تجربیات گذشته در یک بافر پخش ذخیره می شود و به طور تصادفی در طول آموزش نمونه برداری می شود. این به تثبیت فرآیند یادگیری و بهبود عملکرد عامل کمک می کند.

بهینه سازی سیاست پروگزیمال (PPO) یکی دیگر از الگوریتم های یادگیری تقویتی است که در سال های اخیر محبوبیت پیدا کرده است.

PPO یک الگوریتم بهینه سازی خط مشی است که مستقیماً تابع خط مشی را بهینه می کند که وضعیت ها را به اقدامات نگاشت می کند.

از یک تابع هدف جایگزین برای به روز رسانی خط مشی استفاده می کند به گونه ای که به روز رسانی های کوچک خط مشی را تضمین می کند و از فراموشی فاجعه آمیز جلوگیری می کند.

نشان داده شده است که PPO به عملکرد پیشرفته ای در طیف گسترده ای از وظایف دست می یابد و به طور گسترده در تحقیقات و صنعت استفاده می شود.

یک الگوریتم نسبتا جدید در چشم انداز یادگیری تقویتی، Soft Actor-Critic (SAC) است.

SAC یک الگوریتم خارج از سیاست است که مزایای یادگیری Q و بهینه سازی خط مشی را با هم ترکیب می کند.

از یک تابع ارزش نرم برای تخمین پاداش تجمعی مورد انتظار و یک خط مشی تصادفی برای کشف محیط استفاده می کند.

SAC همچنین یک اصطلاح تنظیم آنتروپی را برای تشویق اکتشاف و جلوگیری از همگرایی زودهنگام به سیاستهای غیربهینه معرفی میکند.

این امر باعث میشود که SAC در کارهایی با پاداشهای کم یا فضاهای اقدام مداوم مؤثر باشد.

در نهایت، ما تکرار ارزش تقریبی (PVI) را داریم، الگوریتمی که نقاط قوت تکرار ارزش و بهینهسازی سیاست را ترکیب میکند.

PVI از یک مرحله تکرار مقدار برای به روز رسانی تابع مقدار و یک مرحله بهینه سازی خط مشی برای به روز رسانی خط مشی استفاده می کند.

این فرآیند تکراری به PVI اجازه میدهد تا تعادلی بین اکتشاف و بهرهبرداری پیدا کند که منجر به یادگیری قوی و کارآمد میشود. PVI نتایج امیدوارکنندهای را در حوزههای مختلف از جمله روباتیک و بازی نشان داده است.

در نتیجه، الگوریتمهای یادگیری تقویتی چارچوبی قدرتمند برای آموزش عوامل ارائه میدهند تا بر اساس آزمون و خطا تصمیم بگیرند.

از Q-learning تا PPO، هر الگوریتم نقاط قوت و ضعف خاص خود را دارد که آنها را برای انواع مختلف وظایف مناسب می کند.

این الگوریتمها خواه مدیریت فضاهای حالت با ابعاد بالا باشد یا دستیابی به عملکرد پیشرفته، همچنان مرزهای امکانپذیر در زمینه یادگیری ماشین را پیش میبرند.

بنابراین، دفعه بعد که درباره یادگیری تقویتی می شنوید، درک بهتری از الگوریتم هایی خواهید داشت که آن را هدایت می کنند.

چالش ها و مسیرهای آینده در تحقیقات یادگیری تقویتی

در حالی که یادگیری تقویتی در کاربردهای مختلف نویدبخش است، اما با چالشهای متعددی نیز مواجه است که محققان فعالانه برای غلبه بر آنها تلاش میکنند.

یکی از چالش های اصلی، مبادله اکتشاف و بهره برداری است. در یادگیری تقویتی، عامل باید بین کاوش اقدامات جدید و بهره برداری از دانشی که قبلاً کسب کرده است، تعادل ایجاد کند.

اگر عامل فقط کاوش کند، ممکن است هرگز از بهترین اقدامات سوء استفاده نکند، و اگر فقط بهره برداری کند، ممکن است کشف اقدامات بهتر را از دست بدهد. یافتن تعادل مناسب برای دستیابی به عملکرد مطلوب بسیار مهم است.

چالش دیگر در یادگیری تقویتی، نفرین ابعاد است. با افزایش تعداد حالت ها و اقدامات در یک محیط، پیچیدگی مسئله یادگیری به طور تصاعدی افزایش می یابد.

این امر کاوش و یادگیری در فضاهای با ابعاد بالا را برای عامل دشوار می کند.

محققان در حال بررسی تکنیکهایی مانند تقریب تابع و کاهش ابعاد هستند تا به این چالش رسیدگی کنند و یادگیری تقویتی را در سناریوهای دنیای واقعی امکانپذیرتر کنند.

علاوه بر این، یادگیری تقویتی اغلب به تعداد زیادی تعامل با محیط برای یادگیری مؤثر نیاز دارد.

این امر می تواند زمان بر و پرهزینه باشد، به خصوص در حوزه هایی که تعاملات گران یا خطرناک هستند. برای مقابله با این چالش، محققان در حال بررسی روشهایی برای سرعت بخشیدن به فرآیند یادگیری هستند، مانند انتقال یادگیری، که در آن دانش از یک کار به وظیفه مرتبط دیگر منتقل میشود، و فرا یادگیری، که در آن عامل یاد میگیرد که چگونه کارآمدتر یاد بگیرد.

یکی دیگر از حوزه های مورد توجه در تحقیقات یادگیری تقویتی، موضوع کارایی نمونه است.

الگوریتم های یادگیری تقویتی سنتی اغلب به مقدار قابل توجهی داده برای یادگیری سیاست های بهینه نیاز دارند. با این حال، در بسیاری از سناریوهای دنیای واقعی، جمع آوری داده ها گران یا محدود است.

برای پرداختن به این موضوع، محققان در حال بررسی تکنیک هایی مانند یادگیری تقویتی مبتنی بر مدل هستند، جایی که عامل مدلی از محیط را می آموزد و از آن برای برنامه ریزی و تصمیم گیری استفاده می کند.

این رویکرد می تواند اتکا به تعاملات دنیای واقعی را کاهش دهد و کارایی نمونه را بهبود بخشد.

علاوه بر این چالش ها، ملاحظات اخلاقی نیز در تحقیقات یادگیری تقویتی وجود دارد.

همانطور که عوامل یادگیری تقویتی توانمندتر و مستقل تر می شوند، سوالاتی در مورد تأثیر آنها بر جامعه و پیامدهای ناخواسته بالقوه مطرح می شود.

محققان فعالانه در حال کار بر روی توسعه چارچوب ها و دستورالعمل هایی هستند تا اطمینان حاصل کنند که سیستم های یادگیری تقویتی ایمن، منصفانه و همسو با ارزش های انسانی هستند.

با وجود این چالش ها، آینده یادگیری تقویتی امیدوارکننده به نظر می رسد. محققان در الگوریتمها، تکنیکها و برنامههای کاربردی پیشرفتهای چشمگیری دارند.

یادگیری تقویتی قبلاً موفقیت چشمگیری در حوزه هایی مانند بازی، روباتیک و رانندگی مستقل نشان داده است.

با ادامه تکامل این رشته، میتوان انتظار داشت که شاهد پیشرفتها و کاربردهای هیجانانگیزتر یادگیری تقویتی در صنایع مختلف باشیم.

در نتیجه، یادگیری تقویتی یک زمینه پویا و در حال تحول است که با چالش های متعددی مواجه است.

از مبادله اکتشاف و بهره برداری گرفته تا نفرین ابعاد، محققان به طور فعال روی رسیدگی به این چالش ها کار می کنند تا یادگیری تقویتی را کارآمدتر، موثرتر و اخلاقی تر کنند.

با پیشرفتها و پیشرفتهای مداوم، آینده یادگیری تقویتی پتانسیل زیادی برای تغییر صنایع و حل مشکلات پیچیده دارد.

منبع » آکادمی اشکان مستوفی