Activation function یکی از عناصر اساسی در شبکههای عصبی است که نقش بسیار مهمی در عملکرد و کارایی این شبکهها دارد.

Activation function در شبکه عصبی چیست؟

این تابع، وظیفه تبدیل وزنها و ورودیهای شبکه به خروجی نهایی را بر عهده دارد و به این ترتیب، تعیین میکند که آیا یک نورون باید فعال شود یا خیر.

اهمیت Activation function در شبکه عصبی به دلیل ویژگیهایی که این تابع دارد، بسیار بزرگ است.

اولین و مهمترین ویژگی این تابع، غیرخطی بودن آن است.

این به این معنی است که شبکه عصبی با استفاده از Activation function، قادر است الگوهای پیچیده و غیرخطی را نیز تشخیص دهد و یاد بگیرد.

اگر از یک تابع خطی به عنوان Activation function استفاده شود، شبکه قادر به یادگیری الگوهای پیچیده نخواهد بود و عملکرد آن محدود خواهد بود.

ویژگی دیگر Activation function، ناپیوستگی آن است.

این به این معنی است که این تابع میتواند خروجیهای مختلفی داشته باشد که به صورت ناگهانی تغییر کند.

این ویژگی باعث میشود که شبکه عصبی بتواند به صورت غیرخطی و با تغییرات ناگهانی، الگوهای پیچیده را یاد بگیرد و تطبیق پذیری بالایی داشته باشد.

در نهایت، Activation function تاثیر بسیار زیادی بر سرعت و کارایی شبکه عصبی دارد.

انتخاب یک Activation function مناسب، میتواند باعث افزایش سرعت یادگیری و دقت شبکه شود.

بنابراین، انتخاب درست Activation function بسیار حائز اهمیت است و باید با دقت و با توجه به نوع مسئله مورد نظر، انجام شود.

به طور کلی، Activation function یکی از عناصر اساسی و حیاتی در شبکههای عصبی است که بر عملکرد و کارایی این شبکهها تاثیر بسزایی دارد.

انتخاب درست Activation function، میتواند باعث بهبود عملکرد و دقت شبکه شود و از این رو، اهمیت بسیار زیادی دارد.

انواع مختلف Activation function و کاربردهای آنها

Activation function یکی از عناصر اساسی در شبکههای عصبی است که وظیفه تبدیل ورودیهای شبکه به خروجیهای مورد نظر را بر عهده دارد.

انتخاب مناسب Activation function میتواند تاثیر زیادی بر عملکرد و کارایی شبکه داشته باشد.

در این مقاله، به بررسی انواع مختلف Activation function و کاربردهای آنها میپردازیم.

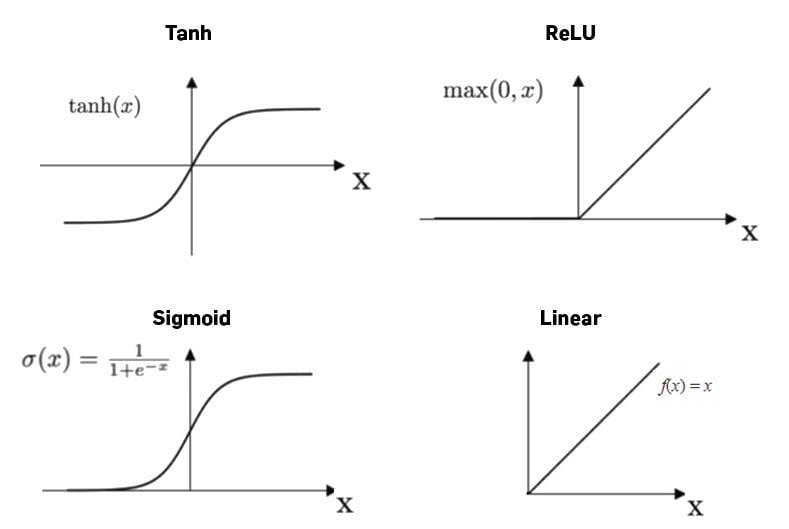

یکی از انواع معروف Activation function، تابع سیگموید است که وظیفه تبدیل ورودیهای شبکه به مقادیر بین صفر و یک را دارد.

این تابع معمولا برای مسائل دستهبندی استفاده میشود ولی مشکلاتی مانند مشکل کاهش گرادیان را دارد.

تابع ReLU یکی دیگر از Activation function های محبوب است که ورودیهای منفی را صفر و ورودیهای مثبت را بدون تغییر باقی میگذارد.

این تابع به خوبی با مشکل کاهش گرادیان مقابله میکند و عموما برای شبکههای عمیق استفاده میشود.

تابع Tanh نیز یک Activation function دیگر است که وظیفه تبدیل ورودیها به مقادیر بین منفی یک و مثبت یک را دارد.

این تابع نسبت به تابع سیگموید بهتر عمل میکند ولی همچنان مشکل کاهش گرادیان را دارد.

تابع Leaky ReLU یک نسخه اصلاح شده از تابع ReLU است که برای جلوگیری از مشکل نگهداری گرادیان در ورودیهای منفی استفاده میشود.

این تابع به خوبی با مشکل کاهش گرادیان مقابله میکند و عموما برای شبکههای عمیق استفاده میشود.

در نهایت، تابع Softmax یک Activation function خاص است که برای مسائل دستهبندی چند کلاسه استفاده میشود.

این تابع ورودیهای شبکه را به احتمالات مربوط به هر کلاس تبدیل میکند و معمولا در لایه آخر شبکه استفاده میشود.

با توجه به انواع مختلف Activation function و کاربردهای آنها، انتخاب مناسب Activation function بر اساس نوع مسئله و ساختار شبکه بسیار مهم است و میتواند تاثیر زیادی بر عملکرد و کارایی شبکه داشته باشد.

تاثیر انتخاب Activation function بر عملکرد شبکه عصبی

Activation function یکی از عناصر اساسی در طراحی و عملکرد شبکه های عصبی است.

این تابع مسئول انتقال سیگنال های ورودی به خروجی های شبکه می باشد و تاثیر بسزایی بر عملکرد و کارایی شبکه دارد.

از آنجا که Activation function نقش مهمی در شبکه های عصبی دارد، انتخاب صحیح آن بسیار حیاتی است.

انتخاب یک Activation function مناسب می تواند به بهبود عملکرد شبکه کمک کند و عملکرد آن را بهبود بخشد.

برعکس، انتخاب نادرست Activation function می تواند منجر به مشکلاتی مانند مشکل در آموزش شبکه، افت کارایی و یا حتی عدم توانایی شبکه در یادگیری الگوهای پیچیده شود.

در انتخاب Activation function باید به چندین عامل توجه داشت.

اولین عامل، نوع مسئله مورد نظر است.

برای مسائل دسته بندی، معمولاً از Activation function هایی مانند Sigmoid یا Softmax استفاده می شود، در حالی که برای مسائل رگرسیون از Activation function هایی مانند ReLU یا Tanh استفاده می شود.

عامل دیگری که باید در نظر گرفته شود، نوع داده های ورودی است.

برای داده هایی که از مقیاس مختلفی برخوردار هستند، Activation function هایی که به خوبی با این نوع داده ها سازگاری دارند باید انتخاب شوند.

در نهایت، معماری شبکه نیز باید در انتخاب Activation function مد نظر قرار گیرد.

برای شبکه های عمیق، Activation function هایی که از مشکل کاهش گرادیان مانند ReLU استفاده می شود، معمولاً بهترین انتخاب هستند.

به طور کلی، انتخاب Activation function مناسب یکی از عوامل کلیدی در بهبود عملکرد و کارایی شبکه های عصبی است.

بنابراین، برای دستیابی به نتایج بهتر، انتخاب دقیق و شناخته شده Activation function بسیار حائز اهمیت است.

مقایسه بین Activation function های مختلف و مزایا و معایب آنها

Activation function یکی از عناصر اساسی در شبکههای عصبی است که وظیفه تبدیل ورودیهای شبکه به خروجیهای مورد نظر را دارد.

انتخاب مناسب Activation function میتواند تأثیر زیادی بر عملکرد و کارایی شبکه داشته باشد.

در این مقاله، به مقایسه بین Activation function های مختلف و مزایا و معایب آنها میپردازیم.

یکی از Activation function های معروف در شبکههای عصبی، تابع فعالسازی ReLU است که به صورت f(x) = max(0, x) تعریف میشود.

این تابع به دلیل سادگی و سرعت بالای آموزش، یکی از پرکاربردترین Activation function ها است.

اما یکی از معایب آن این است که ممکن است با مشکل Gradient Vanishing روبهرو شود.

تابع فعالسازی Sigmoid یکی دیگر از Activation function های معروف است که به صورت f(x) = 1 / (1 + exp(-x)) تعریف میشود.

این تابع برای مسائل دستهبندی باینری مناسب است اما مشکل Gradient Vanishing را دارد و ممکن است در شبکههای عمیق عملکرد مناسبی نداشته باشد.

تابع فعالسازی Tanh نیز یکی از Activation function های پرکاربرد است که به صورت f(x) = tanh(x) تعریف میشود.

این تابع مشکل Gradient Vanishing را کمتری نسبت به Sigmoid دارد اما همچنان ممکن است با مشکل Gradient Vanishing روبهرو شود.

Activation function های دیگری مانند Leaky ReLU، PReLU، ELU و SELU نیز وجود دارند که هرکدام مزایا و معایب خاص خود را دارند و برای مسائل خاصی مناسب هستند.

در نهایت، انتخاب Activation function مناسب بستگی به نوع مسئله، حجم داده، سرعت آموزش و سایر عوامل دارد.

برای بهبود عملکرد شبکه، ممکن است نیاز باشد تا چندین Activation function را با یکدیگر ترکیب کرده و یا تغییراتی در آنها ایجاد کرد.

روشهای بهینهسازی برای انتخاب بهترین Activation function در شبکه عصبی

روشهای بهینهسازی برای انتخاب بهترین Activation function در شبکه عصبی میتواند برای بهبود عملکرد و کارایی شبکه بسیار مهم باشد.

Activation function یکی از عناصر اصلی در طراحی شبکه عصبی است که وظیفه تبدیل ورودیهای شبکه به خروجیهای مورد نظر را دارد.

یکی از روشهای معمول برای انتخاب Activation function، استفاده از توابع معروفی مانند Sigmoid، Tanh و ReLU است.

اما انتخاب صحیح تابع Activation میتواند بهبود قابل توجهی در عملکرد شبکه داشته باشد.

برای این منظور، میتوان از روشهای بهینهسازی مختلفی استفاده کرد.

یکی از روشهای معمول برای بهینهسازی Activation function، استفاده از الگوریتمهای بهینهسازی مانند Gradient Descent و Stochastic Gradient Descent است.

این الگوریتمها به شبکه کمک میکنند تا بهترین پارامترهای Activation function را پیدا کند و عملکرد بهینه را ارائه دهد.

علاوه بر این، از روشهای بهینهسازی مبتنی بر یادگیری مانند Grid Search و Random Search نیز میتوان برای انتخاب بهترین Activation function استفاده کرد.

این روشها به شبکه کمک میکنند تا به صورت خودکار و با استفاده از تلاش و تجربه، بهترین تابع Activation را انتخاب کند.

به طور کلی، استفاده از روشهای بهینهسازی مناسب برای انتخاب بهترین Activation function در شبکه عصبی میتواند بهبود قابل توجهی در عملکرد و کارایی شبکه داشته باشد.

انتخاب صحیح Activation function باعث افزایش سرعت و دقت شبکه میشود و در نهایت منجر به بهبود عملکرد کلی شبکه میشود.

منبع » آکادمی اشکان مستوفی