نزول گرادیان دسته ای یا Batch Gradient Descent یک مفهوم اساسی در یادگیری ماشینی که نقش مهمی در بهینه سازی مدل ها و بهبود عملکرد آنها دارد.

در این مقاله، ما به اصول اولیه نزول گرادیان دسته ای می پردازیم و نحوه عملکرد آن را درک می کنیم.

برای شروع، بیایید تعریف کنیم که شیب نزول چیست.

درک مبانی نزول گرادیان دسته ای در یادگیری ماشین

به زبان ساده، Batch Gradient Descent گرادیان نزول یک الگوریتم بهینهسازی است که برای به حداقل رساندن تابع هزینه یک مدل یادگیری ماشین استفاده میشود.

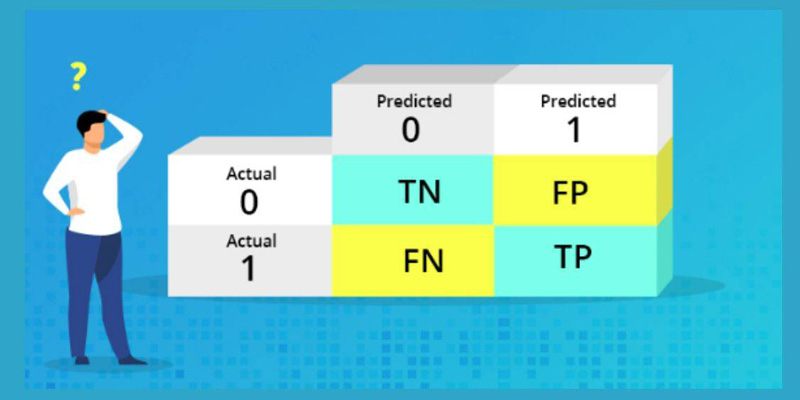

تابع هزینه تفاوت بین خروجی پیش بینی شده و خروجی واقعی را اندازه گیری می کند.

هدف از شیب نزول یافتن مجموعه ای از پارامترهای مدل است که این تابع هزینه را به حداقل می رساند.

اکنون، بیایید روی نزول گرادیان دسته ای تمرکز کنیم.

Batch gradient descent گونه ای از گرادیان نزول است که پارامترهای مدل را با استفاده از کل مجموعه داده آموزشی در هر تکرار به روز می کند.

این بدان معناست که شیب تابع هزینه را با توجه به هر پارامتر با در نظر گرفتن تمام مثال های آموزشی به طور همزمان محاسبه می کند.

مزیت استفاده از شیب نزولی دسته ای این است که تخمین دقیق تری از گرادیان واقعی را در مقایسه با انواع دیگر مانند نزول گرادیان تصادفی ارائه می دهد.

با در نظر گرفتن کل مجموعه داده، نزول گرادیان دستهای ساختار کلی دادهها را در نظر میگیرد و از نویزهایی که میتوان با نمونههای آموزشی فردی معرفی کرد جلوگیری کرد.

با این حال، این مزیت هزینه دارد.

از آنجایی که نزول گرادیان دسته ای از کل مجموعه داده استفاده می کند، می تواند از نظر محاسباتی گران باشد، به خصوص برای مجموعه داده های بزرگ.

علاوه بر این، نیاز به قرار گرفتن کل مجموعه داده در حافظه دارد که ممکن است همیشه امکان پذیر نباشد.

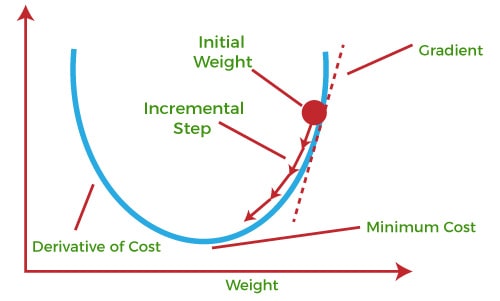

برای انجام نزول گرادیان دسته ای، باید یک سری مراحل را دنبال کنیم.

ابتدا، پارامترهای مدل را با مقادیری تصادفی مقداردهی اولیه می کنیم.

سپس، تابع هزینه را با استفاده از مقادیر پارامتر فعلی و کل مجموعه داده آموزشی محاسبه میکنیم.

سپس، گرادیان تابع هزینه را با توجه به هر پارامتر محاسبه می کنیم.

این گرادیان جهتی را نشان می دهد که در آن پارامترها باید برای به حداقل رساندن تابع هزینه به روز شوند.

پس از محاسبه گرادیان، پارامترهای مدل را با برداشتن یک قدم کوچک در جهت مخالف گرادیان به روز می کنیم.

این اندازه گام با نرخ یادگیری تعیین می شود که سرعت به روز رسانی پارامترها را کنترل می کند.

نرخ یادگیری بیشتر میتواند منجر به همگرایی سریعتر شود، اما ممکن است باعث افزایش بیش از حد شود.

از سوی دیگر، نرخ یادگیری کمتر می تواند ثبات را تضمین کند اما ممکن است منجر به همگرایی کندتر شود.

ما این مراحل را به طور مکرر تکرار می کنیم تا زمانی که تابع هزینه همگرا شود یا به یک آستانه از پیش تعریف شده برسد.

در هر تکرار، پارامترهای مدل به مقادیر بهینه نزدیکتر می شوند که تابع هزینه را به حداقل می رساند.

این فرآیند بهروزرسانی مکرر پارامترها چیزی است که به مدل اجازه میدهد از دادهها بیاموزد و عملکرد خود را بهبود بخشد.

در نتیجه، نزول گرادیان دسته ای یک الگوریتم بهینه سازی قدرتمند در یادگیری ماشین است که به ما کمک می کند مجموعه بهینه پارامترهای مدل را پیدا کنیم.

با در نظر گرفتن کل مجموعه داده آموزشی، تخمین دقیق تری از گرادیان واقعی ارائه می دهد.

با این حال، می تواند از نظر محاسباتی گران باشد و نیاز به کل مجموعه داده در حافظه دارد.

درک اصول اولیه شیب دسته ای برای هر کسی که در زمینه یادگیری ماشین کار می کند ضروری است، زیرا پایه و اساس بسیاری از تکنیک های بهینه سازی پیشرفته را تشکیل می دهد.

مزایا و معایب Batch Gradient Descent در یادگیری ماشین

Batch gradient descent یک الگوریتم بهینه سازی محبوب است که در یادگیری ماشین استفاده می شود.

این به دلیل سادگی و کارایی آن در یافتن راه حل بهینه برای یک مسئله معین به طور گسترده مورد استفاده قرار می گیرد.

با این حال، مانند هر الگوریتم دیگری، مجموعه ای از مزایا و معایب خاص خود را دارد.

یکی از مزایای اصلی شیب نزولی دسته ای این است که با توجه به اینکه نرخ یادگیری به درستی تنظیم شده است، همگرایی را به حداقل جهانی تابع هزینه تضمین می کند.

این بدان معنی است که همیشه بهترین راه حل ممکن را برای مشکل موجود پیدا خواهد کرد.

این به ویژه در مواردی مفید است که تابع هزینه غیر محدب است و دارای حداقل های محلی متعدد است.

یکی دیگر از مزایای نزول گرادیان دسته ای این است که به راحتی می توان آن را موازی کرد.

از آنجایی که الگوریتم کل مجموعه داده آموزشی را در هر تکرار پردازش میکند، میتوان حجم کار را در چندین پردازنده یا ماشین توزیع کرد.

این می تواند به طور قابل توجهی روند آموزش را سرعت بخشد، به خصوص زمانی که با مجموعه داده های بزرگ سروکار دارید.

علاوه بر این، نزول گرادیان دسته ای همگرایی پایدار و صاف را فراهم می کند.

با در نظر گرفتن کل مجموعه داده آموزشی در هر تکرار، ساختار کلی داده ها را در نظر می گیرد و از گیر افتادن در حداقل های محلی جلوگیری می کند.

این باعث می شود که برای بسیاری از وظایف یادگیری ماشینی انتخابی قابل اعتماد باشد.

با این حال، نزول گرادیان دسته ای معایبی نیز دارد.

یکی از اشکالات اصلی آن هزینه محاسباتی بالای آن است.

پردازش کل مجموعه داده های آموزشی در هر تکرار می تواند زمان بر باشد، به خصوص زمانی که با مجموعه داده های بزرگ سروکار داریم.

این می تواند کاربرد آن را در سناریوهای یادگیری آنی یا آنلاین که در آن به روز رسانی سریع مورد نیاز است، محدود کند.

یکی دیگر از معایب نزول گرادیان دسته ای، نیاز به حافظه بالای آن است.

از آنجایی که نیاز به ذخیره کل مجموعه داده آموزشی در حافظه دارد، میتواند به حافظه فشرده باشد، به خصوص زمانی که با مجموعه دادههای بزرگ سروکار داریم.

این می تواند یک عامل محدود کننده در شرایطی باشد که منابع حافظه محدود است.

بعلاوه، نزول شیب دسته ای می تواند در نقاط زین یا فلات ها گیر کند، که مناطقی از تابع هزینه هستند که در آن شیب نزدیک به صفر است اما در حداقل نیست.

این می تواند همگرایی را کاهش دهد و یافتن راه حل بهینه را دشوارتر کند.

برای غلبه بر این مشکل، می توان از تکنیک های اضافی مانند سرعت یا نرخ یادگیری تطبیقی استفاده کرد.

در نتیجه، نزول گرادیان دسته ای یک الگوریتم بهینه سازی قدرتمند در یادگیری ماشین با مجموعه ای از مزایا و معایب خاص خود است.

همگرایی را به حداقل جهانی تضمین می کند، می تواند به راحتی موازی شود و همگرایی پایدار را فراهم می کند.

با این حال، می تواند از نظر محاسباتی گران، حافظه فشرده و مستعد گیر کردن در نقاط زین باشد.

درک این معاوضه ها هنگام انتخاب الگوریتم بهینه سازی مناسب برای یک کار خاص یادگیری ماشین بسیار مهم است.

الگوریتم های یادگیری

Batch Gradient Descent یک الگوریتم بهینه سازی محبوب است که در الگوریتم های یادگیری ماشین استفاده می شود.

به طور گسترده در کاربردهای مختلف از جمله رگرسیون خطی، رگرسیون لجستیک و شبکه های عصبی استفاده می شود.

در این مقاله به بررسی مفهوم Batch Gradient Descent و نحوه پیاده سازی آن در الگوریتم های یادگیری ماشین می پردازیم.

برای درک Batch Gradient Descent، اجازه دهید ابتدا بحث کنیم که گرادیان نزول چیست.

گرادیان نزول یک الگوریتم بهینه سازی است که هدف آن یافتن حداقل یک تابع است.

در زمینه یادگیری ماشین، این تابع معمولاً یک تابع هزینه است که خطای بین مقادیر پیشبینیشده و واقعی را اندازهگیری میکند.

هدف این است که با تنظیم پارامترهای مدل این خطا را به حداقل برسانیم.

Batch Gradient Descent نوعی از گرادیان نزول است که پارامترهای مدل را با استفاده از کل مجموعه داده آموزشی در هر تکرار به روز می کند.

به این معنی که گرادیان تابع هزینه را با توجه به هر پارامتر با در نظر گرفتن تمام مثال های آموزشی محاسبه می کند.

سپس از گرادیان ها برای به روز رسانی پارامترها در جهتی استفاده می شود که تابع هزینه را به حداقل می رساند.

یکی از مزیت های Batch Gradient Descent این است که با توجه به اینکه نرخ یادگیری به طور مناسب انتخاب شده است، همگرایی را به حداقل جهانی تابع هزینه تضمین می کند.

با این حال، می تواند از نظر محاسباتی گران باشد، به خصوص زمانی که با مجموعه داده های بزرگ سروکار داریم.

از آنجایی که از کل مجموعه داده آموزشی در هر تکرار استفاده می کند، به حافظه و قدرت پردازش زیادی نیاز دارد.

برای پیاده سازی Batch Gradient Descent، ابتدا پارامترهای مدل را به صورت تصادفی یا با مقادیری از پیش تعریف شده مقداردهی اولیه می کنیم.

سپس، ما گرادیان های تابع هزینه را با توجه به هر پارامتر با استفاده از کل مجموعه داده آموزشی محاسبه می کنیم.

سپس از این گرادیان ها برای به روز رسانی پارامترها با کم کردن حاصل ضرب نرخ یادگیری و گرادیان ها از مقادیر پارامتر فعلی استفاده می شود.

این فرآیند برای تعداد ثابتی از تکرارها یا تا زمانی که تابع هزینه به حداقل برسد تکرار می شود.

در هر تکرار، کل مجموعه داده آموزشی برای محاسبه گرادیان ها و به روز رسانی پارامترها استفاده می شود.

به همین دلیل است که به آن نزول گرادیان “دسته ای” می گویند، زیرا کل نمونه های آموزشی را در هر تکرار در نظر می گیرد.

یکی از اشکالات Batch Gradient Descent این است که هنگام برخورد با مجموعه داده های بزرگ می تواند کند باشد.

از آنجایی که از کل مجموعه داده آموزشی در هر تکرار استفاده می کند، به منابع محاسباتی زیادی نیاز دارد.

اینجاست که انواع دیگر شیب نزول، مانند نزول گرادیان تصادفی و شیب نزولی مینی دسته ای، وارد بازی می شوند.

این گونهها از زیرمجموعهای از مجموعه داده آموزشی در هر تکرار استفاده میکنند، که هزینه محاسباتی را کاهش میدهد در حالی که همچنان به حداقل میرسد.

در نتیجه، Batch Gradient Descent یک الگوریتم بهینه سازی قدرتمند است که در الگوریتم های یادگیری ماشین استفاده می شود.

این پارامترهای مدل را با استفاده از کل مجموعه داده آموزشی در هر تکرار به روز می کند و همگرایی را به حداقل جهانی تابع هزینه تضمین می کند.

با این حال، می تواند از نظر محاسباتی گران باشد، به خصوص زمانی که با مجموعه داده های بزرگ سروکار داریم.

انواع دیگر شیب نزولی، مانند نزول گرادیان تصادفی و شیب دسته ای کوچک، جایگزین های سریع تری ارائه می دهند و در عین حال نتایج خوبی را به دست می آورند.

مقایسه نزول گرادیان دسته ای با سایر تکنیک های گرادیان نزول در یادگیری ماشین

نزول گرادیان دسته ای (BGD) یک الگوریتم بهینه سازی محبوب است که در یادگیری ماشین استفاده می شود.

این به دلیل سادگی و کارایی آن در یافتن راه حل بهینه برای یک مسئله معین به طور گسترده مورد استفاده قرار می گیرد.

در این مقاله، ما BGD را با سایر تکنیکهای نزولی گرادیان که معمولاً در یادگیری ماشین استفاده میشوند، مقایسه میکنیم.

برای درک BGD، اجازه دهید ابتدا بحث کنیم که نزول گرادیان چیست.

گرادیان نزول یک الگوریتم بهینه سازی است که هدف آن به حداقل رساندن یک تابع هزینه معین است.

این کار را با تنظیم مکرر پارامترهای یک مدل در جهت شیب دارترین نزول انجام می دهد.

هدف یافتن حداقل جهانی تابع هزینه است که نشان دهنده بهترین راه حل ممکن است.

یکی از مزایای اصلی BGD این است که کل مجموعه داده های آموزشی را در هر تکرار در نظر می گیرد.

این بدان معنی است که تمام اطلاعات موجود را برای به روز رسانی پارامترهای مدل در نظر می گیرد.

این می تواند هنگام برخورد با مجموعه داده های بزرگ مفید باشد، زیرا تضمین می کند که مدل بر روی تمام داده های موجود آموزش داده شده است.

با این حال، این مزیت هزینه دارد.

BGD می تواند از نظر محاسباتی گران باشد، به خصوص زمانی که با مجموعه داده های بزرگ سروکار داریم.

از آنجایی که کل مجموعه داده را در هر تکرار در نظر می گیرد، به حافظه و قدرت پردازش زیادی نیاز دارد.

این می تواند BGD را برای برنامه های خاص غیرعملی کند، به خصوص در هنگام کار با منابع محدود.

برای پرداختن به این موضوع، سایر تکنیکهای نزول گرادیان توسعه یافتهاند.

یکی از این تکنیک ها، نزول گرادیان تصادفی (SGD) است.

برخلاف BGD، SGD به طور تصادفی یک نقطه داده واحد را از مجموعه داده های آموزشی در هر تکرار انتخاب می کند.

این امر بار محاسباتی را کاهش می دهد، زیرا تنها به بخش کوچکی از مجموعه داده برای به روز رسانی پارامترهای مدل نیاز دارد.

با این حال، این تصادفی نویز را وارد فرآیند بهینهسازی میکند که میتواند منجر به همگرایی کندتر و نتایج دقیقتر در مقایسه با BGD شود.

تکنیک دیگر نزول گرادیان کوچک دسته ای (MBGD) است.

MBGD یک سازش بین BGD و SGD است.

به طور تصادفی دسته کوچکی از نقاط داده را از مجموعه داده های آموزشی در هر تکرار انتخاب می کند.

این امکان ایجاد تعادل بین کارایی محاسباتی و دقت را فراهم می کند.

MBGD اغلب هنگام برخورد با مجموعه داده های با اندازه متوسط استفاده می شود، زیرا یک مبادله خوب بین BGD و SGD فراهم می کند.

علاوه بر BGD، SGD و MBGD، انواع دیگری از تکنیکهای نزول گرادیان وجود دارد، مانند Momentum، AdaGrad و RMSprop.

این تکنیکها اصلاحات بیشتری را در الگوریتم نزولی گرادیان پایه برای بهبود سرعت و ثبات همگرایی معرفی میکنند.

در نتیجه، BGD یک الگوریتم بهینه سازی قدرتمند است که در یادگیری ماشین استفاده می شود.

کل مجموعه داده آموزشی را در هر تکرار در نظر می گیرد که می تواند به نتایج دقیق تری منجر شود.

با این حال، می تواند از نظر محاسباتی گران باشد، به خصوص زمانی که با مجموعه داده های بزرگ سروکار داریم.

برای پرداختن به این موضوع، سایر تکنیکهای نزولی گرادیان، مانند SGD و MBGD، توسعه یافتهاند.

این تکنیکها تعادلی بین کارایی محاسباتی و دقت فراهم میکنند.

در نهایت، انتخاب تکنیک نزول گرادیان به نیازهای خاص مسئله مورد نظر بستگی دارد.

منبع » آکادمی اشکان مستوفی